LM Studio accelera le prestazioni degli LLM con GPU NVIDIA GeForce RTX e CUDA 12.8

Con l’espansione continua dei casi d’uso dell’intelligenza artificiale, dalla sintesi automatica di testi agli agenti software personalizzati, cresce la richiesta, da parte di sviluppatori e appassionati, di soluzioni più veloci e flessibili per eseguire modelli linguistici di grandi dimensioni (LLM). Eseguirli in locale su PC dotati di GPU NVIDIA GeForce RTX garantisce inferenze ad alte […] L'articolo LM Studio accelera le prestazioni degli LLM con GPU NVIDIA GeForce RTX e CUDA 12.8 proviene da Vgmag.it.

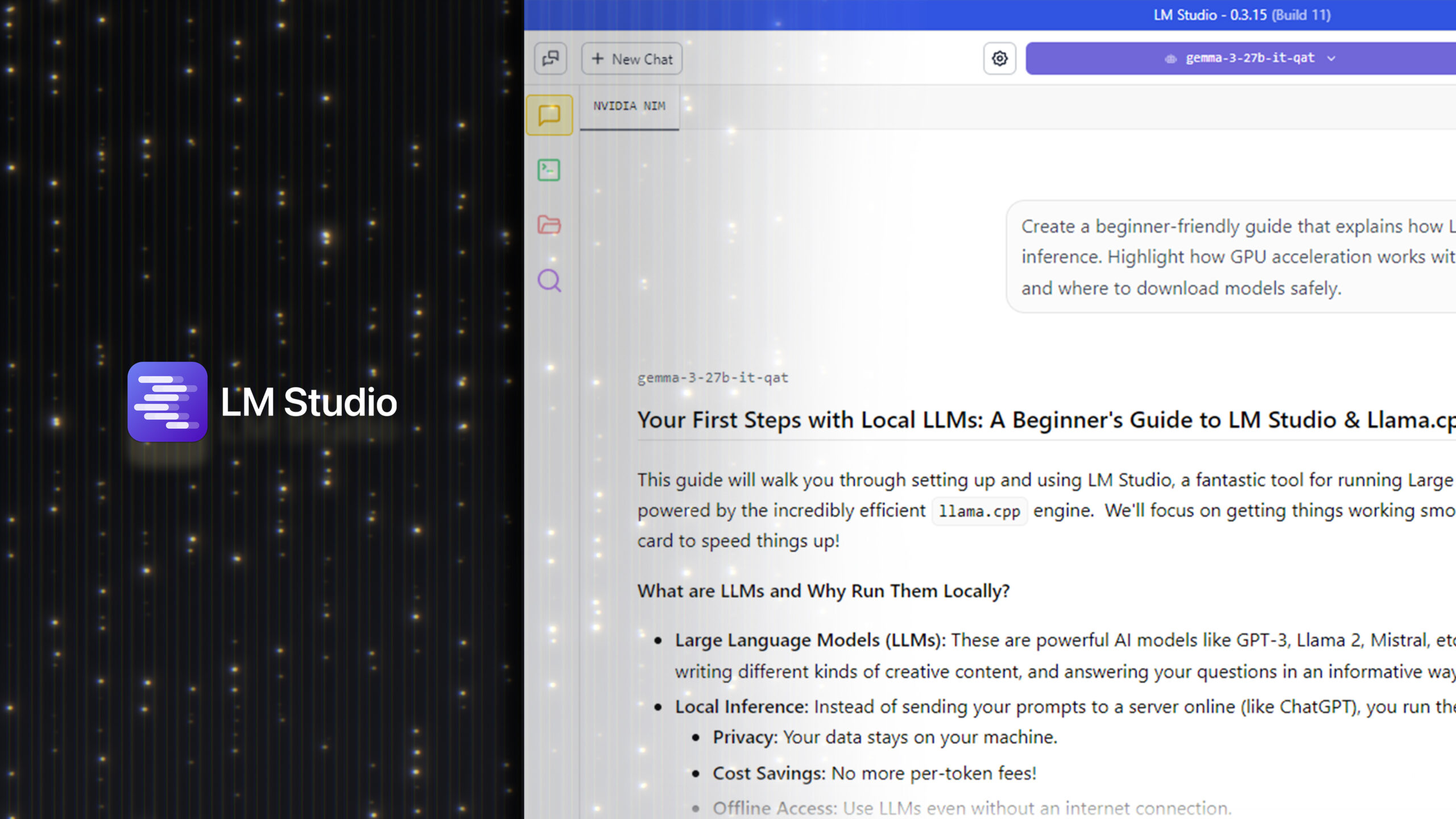

Con l’espansione continua dei casi d’uso dell’intelligenza artificiale, dalla sintesi automatica di testi agli agenti software personalizzati, cresce la richiesta, da parte di sviluppatori e appassionati, di soluzioni più veloci e flessibili per eseguire modelli linguistici di grandi dimensioni (LLM). Eseguirli in locale su PC dotati di GPU NVIDIA GeForce RTX garantisce inferenze ad alte prestazioni, maggiore privacy sui dati e pieno controllo sull’uso e sull’integrazione dell’AI. Strumenti come LM Studio, disponibile in versione di prova gratuita, rendono questo approccio accessibile, permettendo di esplorare e utilizzare gli LLM direttamente sull’hardware dell’utente.LM Studio è oggi uno degli strumenti più diffusi per l’inferenza LLM locale. Basato sul runtime ad alte prestazioni llama.cpp, consente di eseguire i modelli offline e può anche essere usato come endpoint API compatibile con OpenAI, ideale per integrarsi in flussi di lavoro personalizzati.

Con il rilascio della versione 0.3.15, LM Studio migliora sensibilmente le prestazioni su GPU RTX grazie al supporto di CUDA 12.8, riducendo i tempi di upload e migliorando la reattività. L’aggiornamento introduce anche nuove funzioni pensate per gli sviluppatori, come una gestione avanzata dei tool tramite il parametro “tool_choice” e un editor riprogettato per i prompt di sistema. Questi miglioramenti portano LM Studio a offrire il throughput più alto mai registrato su PC RTX AI, garantendo risposte più rapide, un’esperienza d’uso più fluida e tool più potenti per costruire e integrare soluzioni IA in locale.

LM Studio è progettato per offrire la massima flessibilità, adatto tanto a chi vuole sperimentare occasionalmente quanto a chi cerca un’integrazione completa con flussi di lavoro personalizzati. Gli utenti possono utilizzare un’interfaccia chat desktop oppure attivare la modalità sviluppatore per accedere a un endpoint API compatibile con OpenAI, rendendo semplice collegare LLM locali ad applicazioni come VS Code o ad agenti desktop su misura. Un esempio concreto è l’integrazione con Obsidian, l’app per la gestione delle conoscenze basata su markdown. Grazie a plug-in sviluppati dalla community, come Text Generatore Smart Connections, è possibile generare contenuti, riassumere informazioni e interrogare note personali sfruttando LLM locali eseguiti con LM Studio. Questi plug-in si connettono direttamente al server locale, garantendo risposte rapide e private, senza bisogno del cloud. Il motore che accelera LM Studio è llama.cpp, un runtime open source progettato per garantire inferenze efficienti anche su hardware consumer. In collaborazione con le community di LM Studio e llama.cpp, NVIDIA ha introdotto una serie di ottimizzazioni pensate per sfruttare appieno la potenza delle GPU RTX.

Le principali ottimizzazioni includono:

- Abilitazione dei grafici CUDA: Raggruppano più operazioni GPU in un’unica chiamata CPU, riducendo il carico sulla CPU e aumentando il throughput del modello fino al 35%.

- Kernel CUDA Flash Attention: aumenta il throughput fino al 15% migliorando il modo in cui gli LLM elaborano l’attenzione, un’operazione fondamentale nei modelli Transformer. Questa ottimizzazione consente finestre di contesto più lunghe senza aumentare i requisiti di memoria o di calcolo.

- Supporto per le più recenti architetture RTX: l’aggiornamento di LM Studio a CUDA 12.8 garantisce la compatibilità con l’intera gamma di PC RTX AI, dalle GPU GeForce RTX serie 20 alle GPU NVIDIA Blackwell, offrendo agli utenti la flessibilità di scalare i flussi di lavoro AI locali dai laptop ai desktop di fascia alta.

Con un driver compatibile, LM Studio si aggiorna automaticamente al runtime CUDA 12.8, riducendo sensibilmente i tempi di upload dei modelli e migliorando le prestazioni complessive. Questi miglioramenti garantiscono inferenze più fluide e risposte più rapide su tutta la linea di PC RTX AI, massimizzando la produttività su qualsiasi configurazione, dai laptop ai desktop e alle workstation ad alte prestazioni.LM Studio offre preset per i modelli, supporta una vasta gamma di formati di quantizzazione e mette a disposizione controlli avanzati per sviluppatori, come il parametro “tool_choice”, per un’inferenza ottimizzata e personalizzabile. Chi desidera contribuire allo sviluppo può partecipare attivamente tramite il repository GitHub di llama.cpp, che continua a evolversi grazie al lavoro congiunto della community e di NVIDIA, con miglioramenti costanti alle prestazioni. Ogni settimana, il blog RTX AI Garage propone nuovi contenuti e novità sull’intelligenza artificiale sviluppati dalla community, con approfondimenti su microservizi NVIDIA NIM, AI Blueprints, agenti AI, flussi di lavoro creativi, digital humans, applicazioni per la produttività e molto altro, pensati per utenti su PC e workstation AI.

L'articolo LM Studio accelera le prestazioni degli LLM con GPU NVIDIA GeForce RTX e CUDA 12.8 proviene da Vgmag.it.