Optimización de Modelos DeepSeek-R1 Destilados con Hugging Face TGI en Amazon SageMaker AI

DeepSeek AI, una prometedora startup en inteligencia artificial, ha dado un paso significativo en el ámbito de los modelos de […]

DeepSeek AI, una prometedora startup en inteligencia artificial, ha dado un paso significativo en el ámbito de los modelos de lenguaje con el lanzamiento de DeepSeek-R1. Este modelo de última generación se destaca por su innovador proceso de entrenamiento, que va más allá del pre-entrenamiento y ajuste fino tradicionales al incorporar el aprendizaje por refuerzo. Este enfoque avanzado permite obtener resultados más precisos y refinados.

El modelo utiliza un método conocido como cadena de pensamiento (CoT), que descompone consultas complejas en pasos lógicos claros, mejorando así la claridad de las respuestas generadas. Además, DeepSeek-R1 aprovecha la ejecución paralela de subprocesos de NVIDIA para optimizar la eficiencia durante el entrenamiento. Su diseño combina la técnica de ajuste fino supervisado (SFT) con la optimización de política robusta en grupos (GRPO), asegurando resultados transparentes e interpretables.

La colección de modelos DeepSeek se compone de varias variantes, como DeepSeek-V3, que implementa una arquitectura de Mezcla de Expertos (MoE) para activar solo un conjunto limitado de subredes por entrada, aumentando la eficiencia respecto a las redes neuronales tradicionales. Una de sus variantes, DeepSeek-R1-Zero, emplea aprendizaje por refuerzo para mejorar el razonamiento, aunque enfrenta desafíos en legibilidad y mezcla de lenguajes.

DeepSeek-R1 se destaca por su sofisticado proceso de entrenamiento, incorporando datos de SFT mediante muestreo por rechazo y añadiendo un ciclo de aprendizaje reforzado adicional. Esto resulta en un modelo robusto y eficiente. Por otro lado, DeepSeek-R1-Distill representa variantes destiladas de modelos como Qwen y Llama, donde DeepSeek-R1 actúa como maestro, mejorando las capacidades de razonamiento sin alterar su estructura original.

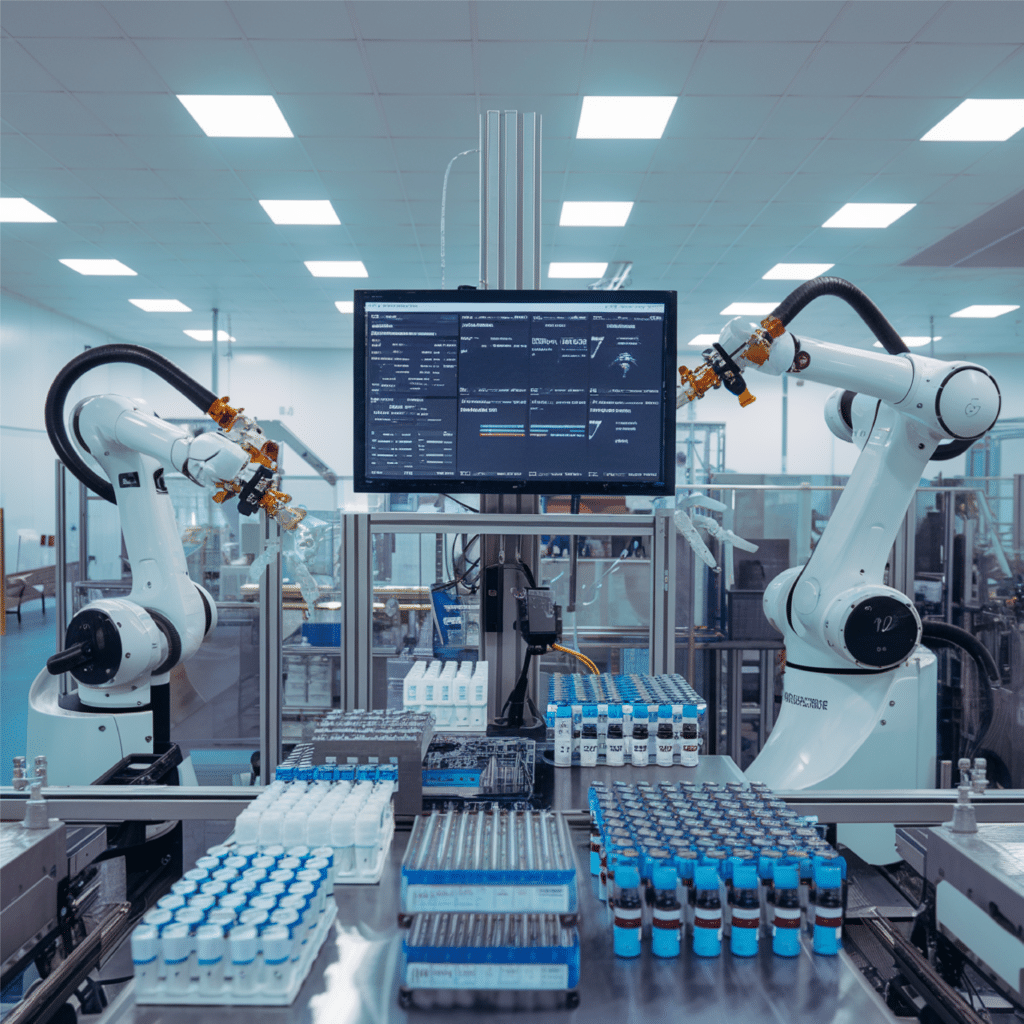

En un avance relacionado, se ha presentado cómo optimizar el alojamiento de los modelos destilados usando Hugging Face Text Generation Inference (TGI) en Amazon SageMaker AI. Este sistema de inferencia gestiona los complejos requisitos de latencia y computación de los avanzados modelos de lenguaje. SageMaker AI facilita esta implementación, permitiendo una integración avanzada con la pila de inferencia de Hugging Face, asegurando un despliegue escalable y rentable.

Entre los beneficios de TGI se incluyen la paralelización de tensores, el batching continuo, la cuantización, decodificación especulativa, optimización de la caché clave-valor y streaming de tokens en tiempo real, mejorando la eficiencia en la generación de texto a gran escala. Amazon SageMaker AI permite el despliegue fácil de modelos DeepSeek-R1, gracias a su autoscalado y balanceo de carga automático, maximizando la eficiencia de recursos y reduciendo costes, sobre todo en horas no pico. Además, se ofrece la flexibilidad de alojar modelos de forma privada mediante cargas en un bucket de S3.

Cada variante de DeepSeek-R1 ha sido rigurosamente evaluada en términos de rendimiento de inferencia, usando métricas críticas que aseguran su escalabilidad y efectividad en aplicaciones prácticas. Este nuevo avance promete revolucionar la forma en que los modelos de lenguaje se entrenan y despliegan, ofreciendo soluciones más eficientes y adaptables para el futuro de la inteligencia artificial.