Detección de Alucinaciones en Sistemas Basados en RAG

La inteligencia artificial generativa ha experimentado un notable crecimiento en popularidad, consolidándose como una herramienta vital en diversas aplicaciones tecnológicas. […]

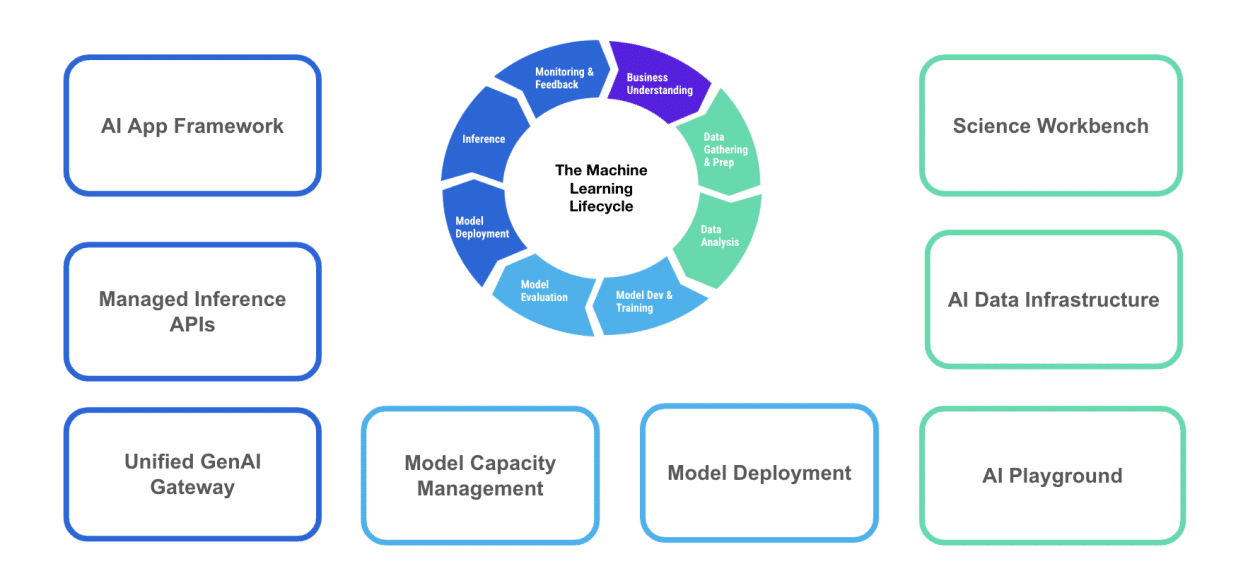

La inteligencia artificial generativa ha experimentado un notable crecimiento en popularidad, consolidándose como una herramienta vital en diversas aplicaciones tecnológicas. Entre las innovaciones destacadas se encuentra la Generación Aumentada por Recuperación (RAG), que se ha convertido en un recurso imprescindible para mejorar la precisión y fiabilidad de las respuestas generadas por modelos de lenguaje avanzados. Este enfoque innovador permite integrar datos adicionales no considerados en el entrenamiento original de los modelos, contribuyendo así a la reducción de información falsa o engañosa, un fenómeno comúnmente conocido como «alucinaciones» en el ámbito de la IA.

La creciente integración de estos sistemas inteligentes en la vida cotidiana y en procesos críticos de toma de decisiones subraya la importancia de detectar y mitigar estas alucinaciones. Hasta ahora, la mayoría de las técnicas se han enfocado principalmente en la pregunta y la respuesta. Sin embargo, RAG, al ofrecer contexto adicional, abre la puerta a nuevas técnicas más efectivas para abordar este desafío.

Para desarrollar un sistema básico de detección de alucinaciones en aplicaciones basadas en RAG, se han evaluado diversos métodos en términos de precisión, recuperación y coste. Las técnicas contemporáneas buscan proporcionar soluciones accesibles que se integren con facilidad en las canalizaciones de RAG, elevando la calidad de las respuestas generadas.

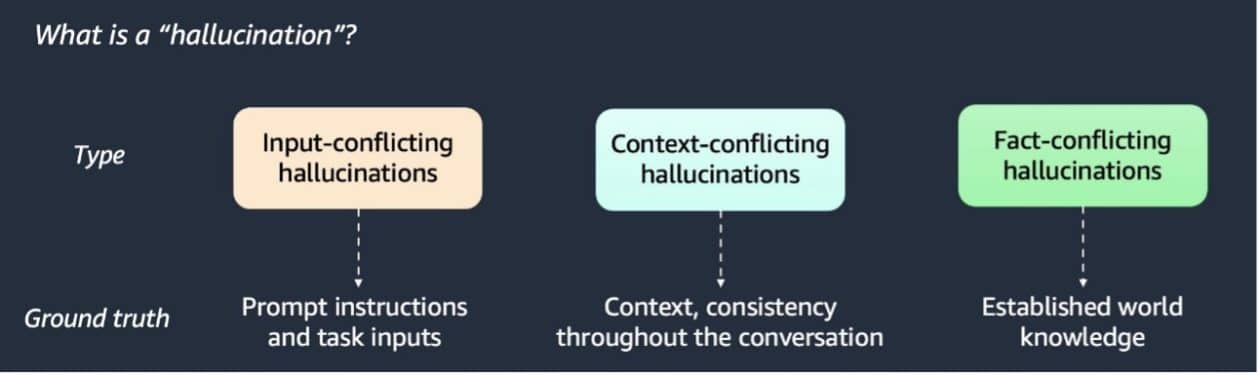

Los expertos han identificado tres tipos principales de alucinaciones y han propuesto múltiples técnicas para su detección. Entre ellas, destacan el uso de detectores basados en modelos de lenguaje grandes (LLM), detectores de similitud semántica y el verificador estocástico BERT. Cada método ha mostrado diferentes niveles de eficacia y rendimiento en pruebas con diversos conjuntos de datos, como artículos de Wikipedia y datos generados sintéticamente.

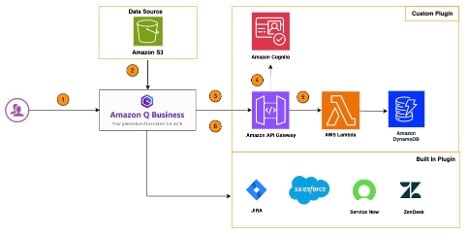

Para implementar estas técnicas, se requiere una cuenta de AWS con acceso a herramientas como Amazon SageMaker y Amazon S3. El funcionamiento efectivo del sistema RAG depende del almacenamiento de tres elementos clave: el contexto relevante a la consulta, la pregunta formulada y la respuesta generada por el modelo de lenguaje.

El uso de la detección basada en modelos de lenguaje grandes permite clasificar la respuesta del sistema RAG evaluando su coherencia con el contexto. Mientras tanto, los métodos de similitud semántica y comparación de tokens ofrecen enfoques alternativos para identificar inconsistencias. En particular, el verificador estocástico BERT ha mostrado una alta eficacia en la recuperación de información, aunque con un coste potencialmente elevado.

Las comparaciones realizadas indican que el método basado en LLM logra un equilibrio favorable entre precisión y coste. Por ello, se recomienda un enfoque híbrido que combine detectores de similitud de tokens con LLM para abordar las alucinaciones de manera eficaz. Este enfoque destaca la importancia de la adaptabilidad y el análisis en las aplicaciones de inteligencia artificial generativa. Con la evolución de las aplicaciones de RAG, los métodos de detección de alucinaciones serán fundamentales para mejorar la fiabilidad y la confianza en estos sistemas.

![Vuelos (Baratos) a Osaka desde España [a Japón desde SOLO 451€ i/v]](https://cdn.guialowcost.es/wp-content/uploads/osaka.jpg)

![Saber Vivir 2019 [Año Completo]](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEhCq2yYo9Hv6OPAUXFccyKuiMt80PPXmYQaaTzpwTIX7s5LnhyXcl7unI_qRqh5T3TxDvfoxv-MO9Zbe8h9VSSiME4005GUGj2yylCt6p8xPSqs_GGY3JkEH9ZLZttRNZezKpOlDU6VO0pOJmQohJ0RZ5CZZuSX7NMKYW9Lh0zfKhSfEJvJNBy7ySDxnvyz/s888/saber-vivir-2019-ano-completo-free-libros.png)

![Saber Vivir 2018 [Año Completo]](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEi18NDw8_59-Ju0wQZXdfo3dNL6WWsqLD-Hok59tO13qEaRfdXQlL4mL86Mv9QWrq3JsLH26G_39ZADaEaMbhjEluv_nJrJgkl2Z6EhzWqJ6FXEJY1e8FiUUi9bgGSFZUn9ygSZNtzXw0NrLgbnNNO-h2EVq5fULSNvvtHZ3MzE1Tjiu2wa50zbepUdAkII/s888/saber-vivir-2018-ano-completo-free-libros.jpg)