Ampliando Modelos de Lenguaje Grandes con Amazon SageMaker AI usando el Protocolo de Contexto del Modelo

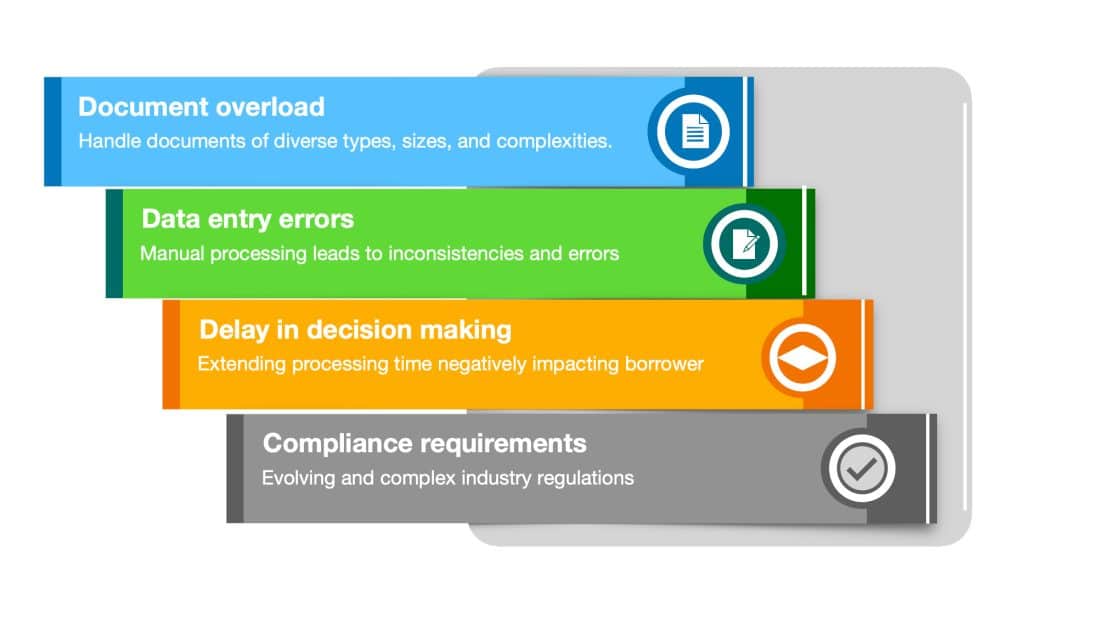

Las organizaciones que implementan agentes y sistemas basados en agentes enfrentan numerosos desafíos al integrar múltiples herramientas y orquestar flujos […]

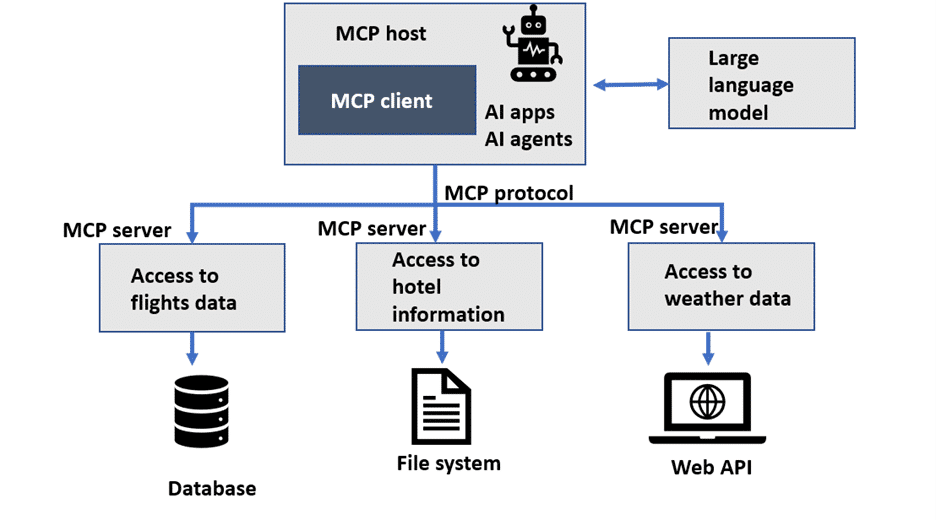

Las organizaciones que implementan agentes y sistemas basados en agentes enfrentan numerosos desafíos al integrar múltiples herramientas y orquestar flujos de trabajo. Un agente típico utiliza llamadas a funciones para interactuar con herramientas externas, como APIs o bases de datos, con el fin de realizar acciones específicas o obtener información que no posee internamente. Esta integración puede complicar el escalado y la reutilización de herramientas en toda la empresa. Por lo tanto, las empresas que desean desplegar agentes a gran escala necesitan una manera uniforme de integrar estas herramientas, independientemente del marco de orquestación utilizado.

En este escenario, el Protocolo de Contexto del Modelo (MCP) se presenta como una solución que estandariza el uso de canales, agentes, herramientas y datos de clientes. Esto crea una experiencia más fluida y eficiente para los clientes, comparado con el manejo de sistemas o agentes fragmentados. Al simplificar y estandarizar la integración de herramientas, los desarrolladores pueden concentrarse en la selección y uso de herramientas sin necesidad de implementar código de integración personalizado.

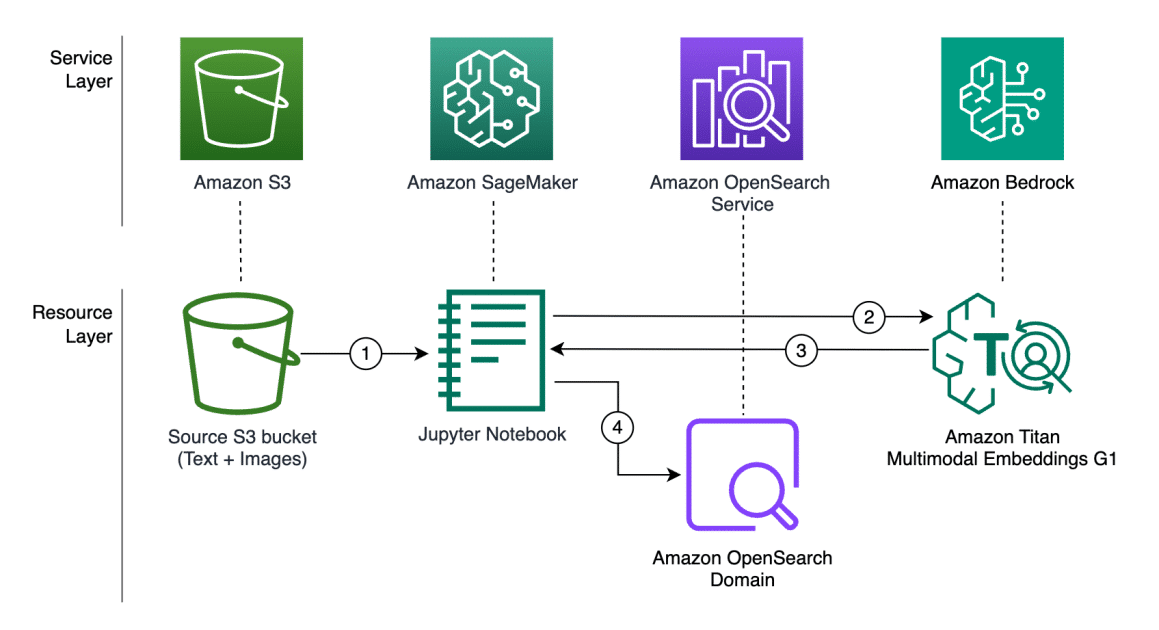

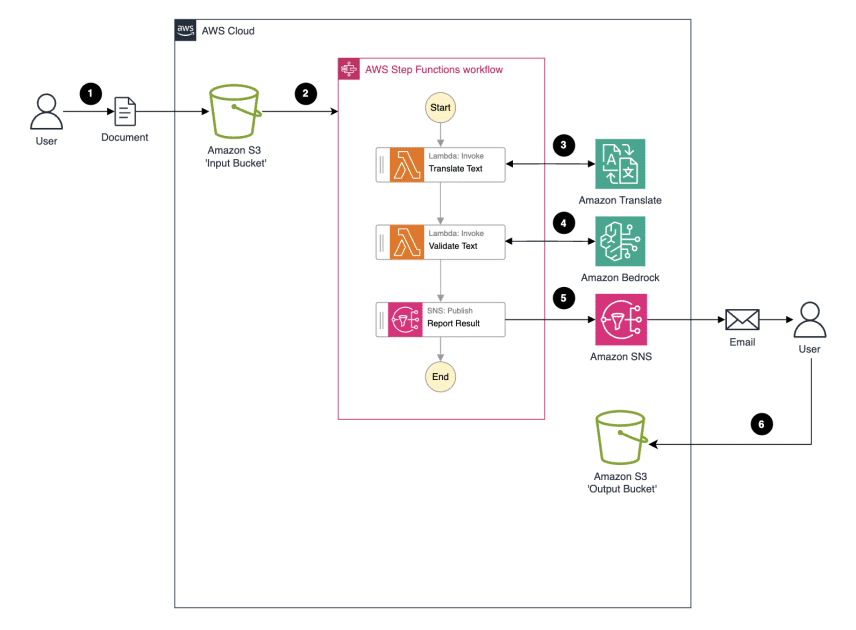

La implementación del MCP requiere una infraestructura escalable para los servidores y un entorno capaz de alojar un modelo de lenguaje grande (LLM), que trabajará con las herramientas proporcionadas por el servidor MCP. Amazon SageMaker AI facilita el alojamiento de LLMs, eliminando las preocupaciones sobre el escalado o la gestión de tareas pesadas. Los servidores MCP pueden alojarse en varias plataformas computacionales de AWS, como Amazon EC2, Amazon ECS, Amazon EKS y AWS Lambda.

El MCP representa un avance respecto a las arquitecturas de microservicios tradicionales. Aunque los microservicios ofrecen modularidad, a menudo requieren integraciones complejas y separadas para cada servicio. Por el contrario, el MCP proporciona una comunicación bidireccional en tiempo real, permitiendo a los sistemas de IA conectarse fácilmente a herramientas externas, servicios API y bases de datos, una ventaja ideal para aplicaciones que requieren acceso modular y confiable a múltiples recursos.

Las opciones para implementar servidores MCP incluyen FastAPI y FastMCP. FastMCP es adecuado para prototipos rápidos y proyectos donde la velocidad es esencial, mientras que FastAPI proporciona flexibilidad y control detallado para flujos de trabajo más complejos.

Esta arquitectura permite a las organizaciones optimizar la integración de IA, reduciendo la necesidad de integraciones personalizadas y mantenimiento. Conectar modelos de forma segura a sistemas críticos se vuelve valioso, facilitando transformaciones en el procesamiento de préstamos, operaciones más ágiles y perspectivas comerciales más profundas. A medida que la IA avanza, el MCP y Amazon SageMaker AI constituyen una base flexible para futuras innovaciones en la inteligencia artificial.

![Viajes National Geographic 2018 [Año Completo]](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEgSbdmMkLJowiHX0D7ZFObOuFNmO_BC-d4TBPocZaO-1H377MsRi8qXfEjnyg1aUn1HxLWIWXR7CHxNwjEcExQZg8c9rDT1Q6_V8m83oz5IrKmgVBZ5WJ8hpSDWqin70s-9CychBPdbg5_Fjfby27JNxbfXvvWfS9dmYU6C3KZ4xyyBQ0v7I2xVAiQYoogH/s888/viajes-national-geographic-2018-ano-completo-freelibros.png)