Personalización de modelos destilados DeepSeek-R1 con recetas de HyperPod en Amazon SageMaker – Parte 1

Las organizaciones de diversas industrias están cada vez más inclinadas a incorporar modelos de inteligencia artificial generativa en sus aplicaciones, […]

Las organizaciones de diversas industrias están cada vez más inclinadas a incorporar modelos de inteligencia artificial generativa en sus aplicaciones, utilizando modelos de fundación (FMs) para mejorar sus procesos. Sin embargo, a medida que emergen nuevos modelos, como los lanzados por DeepSeek, se hace imprescindible personalizar estos modelos para adaptarlos a requerimientos específicos de cada dominio.

La personalización de modelos DeepSeek plantea importantes desafíos, ya que ajustar su arquitectura requiere no solo de experiencia técnica, sino también de habilidades avanzadas para la configuración y el ajuste de parámetros. Las empresas, en consecuencia, se ven frecuentemente obligadas a elegir entre el rendimiento de los modelos y las restricciones prácticas de su implementación, generando una demanda apremiante por soluciones de personalización más sencillas y accesibles.

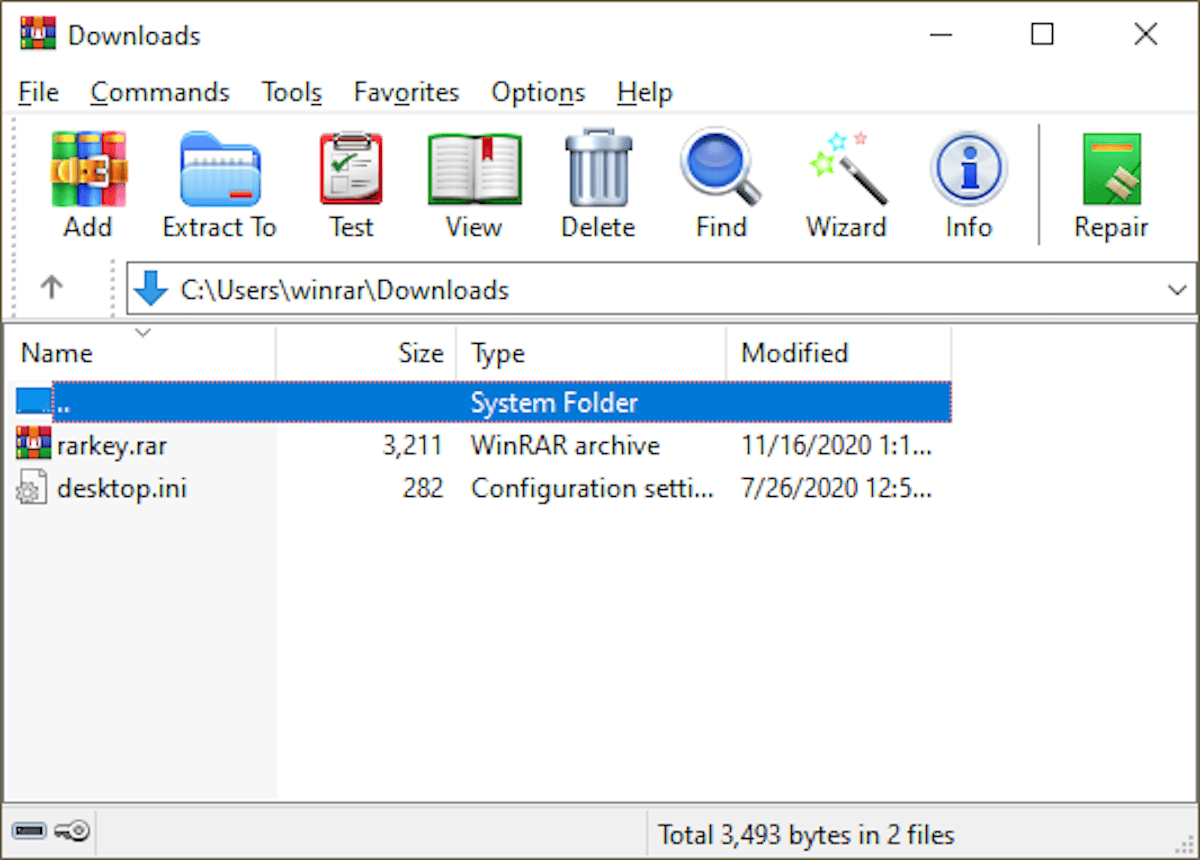

En este contexto, una reciente serie de artículos explora cómo simplificar la personalización de modelos DeepSeek usando flujos de trabajo preconstruidos, denominados «recetas», específicos para el modelo DeepSeek-R1 y sus variantes destiladas. La primera parte de esta serie presenta cómo, mediante el uso de Amazon SageMaker HyperPod, es posible afinar los modelos destilados DeepSeek-R1. Como ejemplo, se detalla la personalización del modelo DeepSeek-R1 Distill Qwen 7b, logrando un aumento promedio del 25% en todas las puntuaciones ROUGE y alcanzando un notable 49% en la puntuación ROUGE-2.

Amazon SageMaker HyperPod ha democratizado el acceso a herramientas avanzadas, permitiendo a científicos de datos y desarrolladores, sin importar su nivel de habilidad, comenzar a entrenar y ajustar modelos de inteligencia artificial generativa en minutos. Estas recetas simplifican tareas esenciales, tales como la carga de conjuntos de datos de entrenamiento y la aplicación de técnicas de entrenamiento distribuidas, reduciendo así el trabajo minucioso que tradicionalmente acompaña a las configuraciones de modelos.

Además, el diseño modular de la arquitectura facilita la escalabilidad y flexibilidad, siendo especialmente adecuado para entrenar modelos de lenguaje de gran tamaño que requieren capacidades de computación distribuidas. Con el fin de asistir a los clientes en la rápida utilización de los modelos DeepSeek, se han lanzado nuevas recetas que permiten ajustar seis modelos, implementando técnicas de ajuste fino supervisado y adaptaciones de bajo rango.

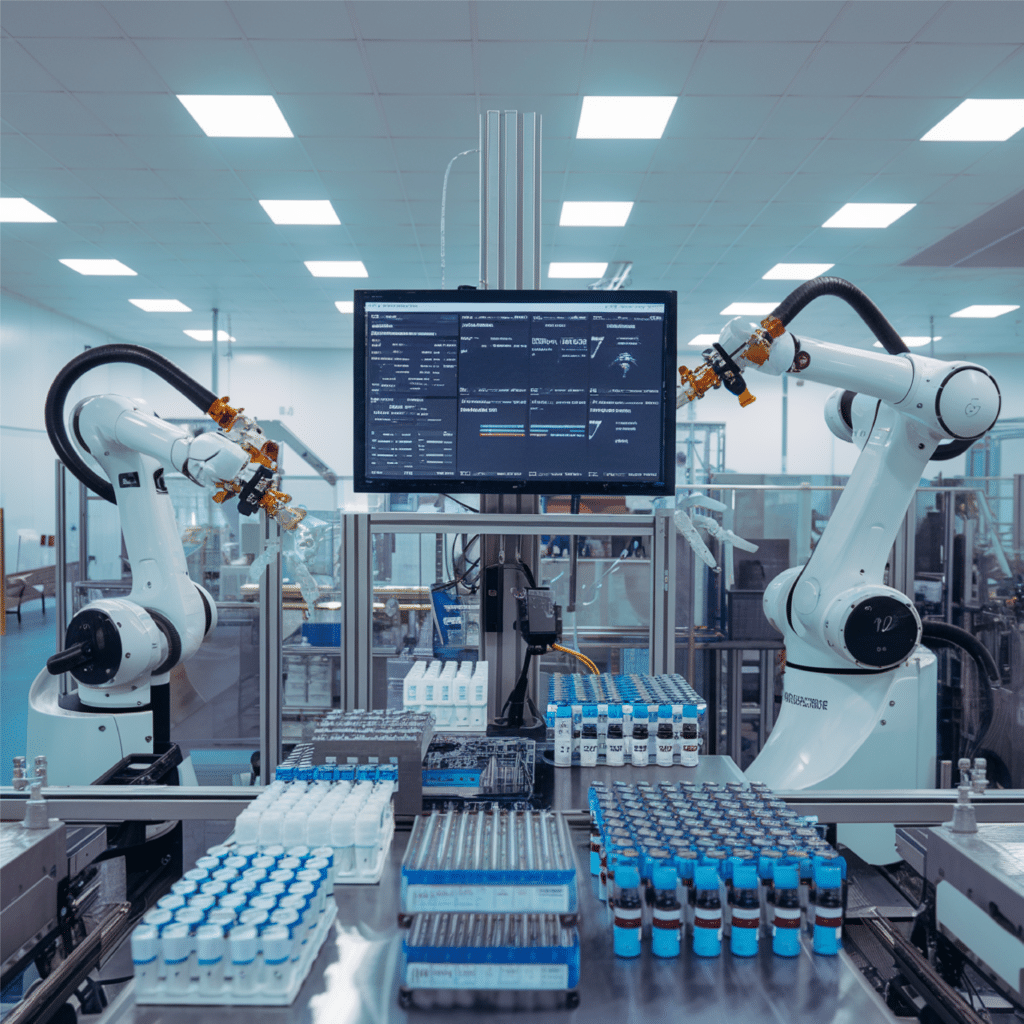

En el sector salud, se contempla un uso innovador de estos avances: el desarrollo de una aplicación de asistencia médica que traduzca información compleja de manera comprensible para el paciente. El ajuste fino del modelo DeepSeek-R1 Distill Qwen 7b, usando un conjunto de datos médicos específico, resulta ser crucial para garantizar que las respuestas se mantengan con el rigor clínico necesario.

Al concluir el ciclo de ajuste, se observa un aumento significativo en la eficiencia del modelo adaptado, reflejado en puntuaciones mejoradas en las métricas ROUGE. Esto sugiere que futuras extensiones en la duración del entrenamiento podrían conllevar mayores mejoras en el rendimiento. Esta serie destaca no solo la innovación en la personalización de la inteligencia artificial, sino también el potencial para optimizar el uso de recursos computacionales en ambientes empresariales.