Daniel Innerarity: "ChatGPT es un pelota, un cuñado pelota”

El filósofo y ensayista analiza en 'Una teoría crítica de la inteligencia artificial' cómo los cambios tecnológicos están influyendo en nuestra capacidad de decidir y apuesta por una mayor democratización de los datos y las capacidades de los algoritmosEl último 'Rincón de pensar' - La vacuna contra la insensatez, por José Antonio Marina Daniel Innerarity (Bilbao, 1959) es de los pensadores que siempre va un paso por delante. Desde su perspectiva de catedrático de Filosofía política y social empezó a analizar el futuro de la democracia antes de que los medios se llenasen de artículos preguntándose por ese incierto devenir. Ahora, en Una teoría crítica de la inteligencia artificial (Galaxia Gutenberg) reflexiona sobre cómo la tecnología no solo está cambiando nuestros hábitos individuales sino a la vez nuestro comportamiento colectivo. Lo hace, como siempre, sin caer en discursos tremendistas, pero también sin el triunfalismo acrítico con que muchos aplauden la irrupción de la inteligencia artificial. En el libro desmonta unos cuantos mitos. El primero es que los datos no son neutrales. Estamos seducidos por la mera cantidad y hay muchos asuntos en la vida que se resuelven con cantidad, con tamaño. La tecnología de datos va a permitir cruzar millones de datos en diagnósticos médicos o tratamientos de enfermedades para obtener resultados y diagnósticos muy precisos. Pero cuando digo que los datos no son neutrales es porque han sido recogidos en un contexto y a veces son utilizados en otro contexto, lo cual plantea problemas. En segundo lugar, los datos requieren interpretación. Yo propondría que nos planteáramos siempre si estamos ante un problema que podemos resolver con aumento de datos o un problema que tenemos que resolver mejorando la interpretación de la realidad. No hacemos más que hablar de Trump, cada día estamos recibiendo impactos de él y de sus decisiones, pero lo que realmente echo de menos es gente que me lo interprete bien. A veces incluso la profusión de datos te impide hacer una buena interpretación. Eso también pasa con la información. Tener mucha información no significa tener buena información. Exactamente. En el libro señala que hay nuevas relaciones de poder que generan análisis de datos. ¿A qué nuevas relaciones de poder se refiere? Hay ricos y pobres de datos en función de quién los tiene, quién tiene la capacidad de almacenarlos e interpretarlos. Un ejemplo, la mayor parte de las fotografías de caras que se han hecho en el mundo se han hecho a hombres blancos. Cuando diseñamos un mecanismo de reconocimiento visual, las fotos con las que se entrena son básicamente fotos de hombres blancos. Eso significa que puede discriminar a los que no lo son. Sí. Por ejemplo, le pusieron una foto de una mujer negra y dijo que era un chimpancé, lo cual es terrible. Tenemos que avanzar mucho en el entrenamiento de los algoritmos, pero sobre todo en que las bases, los datos con los que se entrenan esos algoritmos, sean lo más equitativos y diversos posibles. ¿Una gobernanza algorítmica, como la define usted, limita la democracia? Depende. La gobernanza algorítmica tiene dos promesas que son muy buenas para la democracia, pero también limitadas. Una promesa de objetividad, es decir, en un momento en que nos quejamos de la extrema ideologización y de la polarización, reconducir ciertos debates a su dimensión más técnica, más objetiva, proporcionar más objetividad al discurso y a las narrativas políticas, disminuye el elemento sectario de la política. Pero no elimina la diferencia de opiniones, porque los humanos no nos rendimos ante una objetividad, sino que tenemos diferentes interpretaciones acerca de esa objetividad. La otra promesa es la de la subjetividad, es decir, la promesa de que va a identificar mucho mejor nuestras preferencias y nuestros intereses. Lo cual es verdad, pero también es limitado, porque sabemos que muchas de nuestras preferencias son inducidas por el propio capitalismo que nos hace comprar cosas o generar necesidades que realmente no teníamos. Además, no es que nos identifique a nosotros como individuos, sino que lo hace en función de rasgos que compartimos con grupos de población a los que se supone que pertenecemos. Hay ricos y pobres de datos en función de quién los tiene, quién tiene la capacidad de almacenarlos e interpretarlos. Explica que la gran paradoja de la inteligencia artificial es que solo será general si reconoce sus límites. Y que únicamente podría sustituirnos si renuncia a hacerlo y opta por parecerse a nosotros. Ahora le pido una ucronía: ¿cree que puede acabar sustituyéndonos? No, porque Deep Blue o AlphaGo nos ganan al ajedrez y al Go, que son juegos muy difíciles pero con unas reglas claras, en un tablero donde no se puede hacer

El filósofo y ensayista analiza en 'Una teoría crítica de la inteligencia artificial' cómo los cambios tecnológicos están influyendo en nuestra capacidad de decidir y apuesta por una mayor democratización de los datos y las capacidades de los algoritmos

El último 'Rincón de pensar' - La vacuna contra la insensatez, por José Antonio Marina

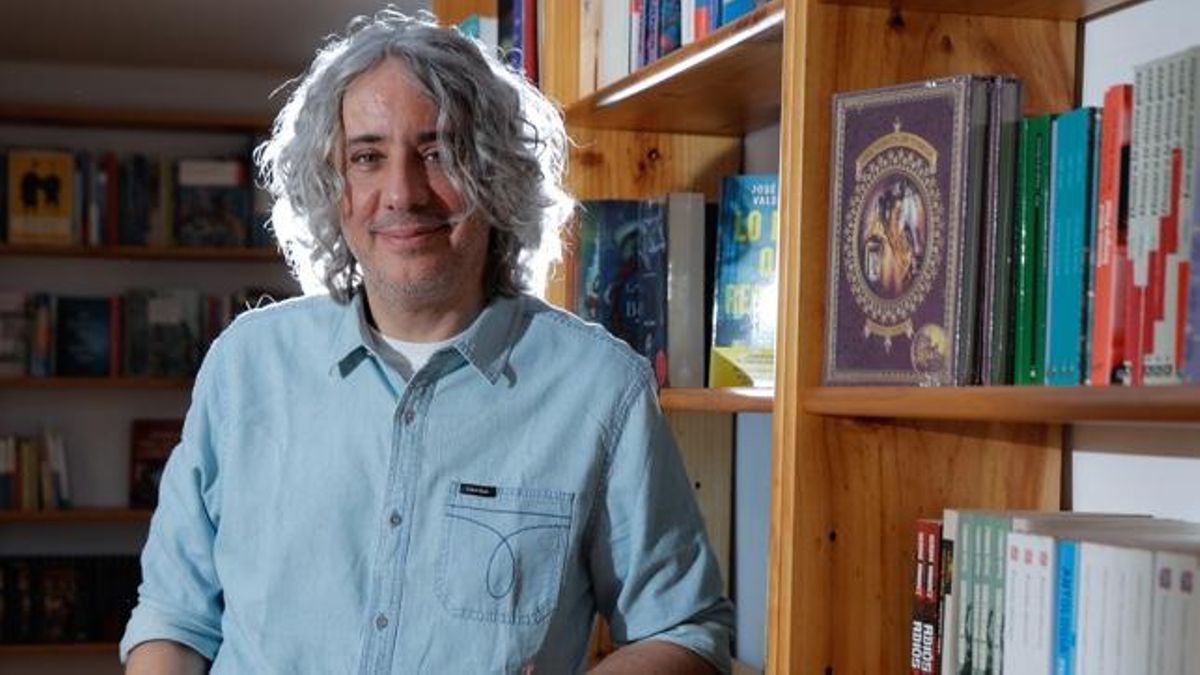

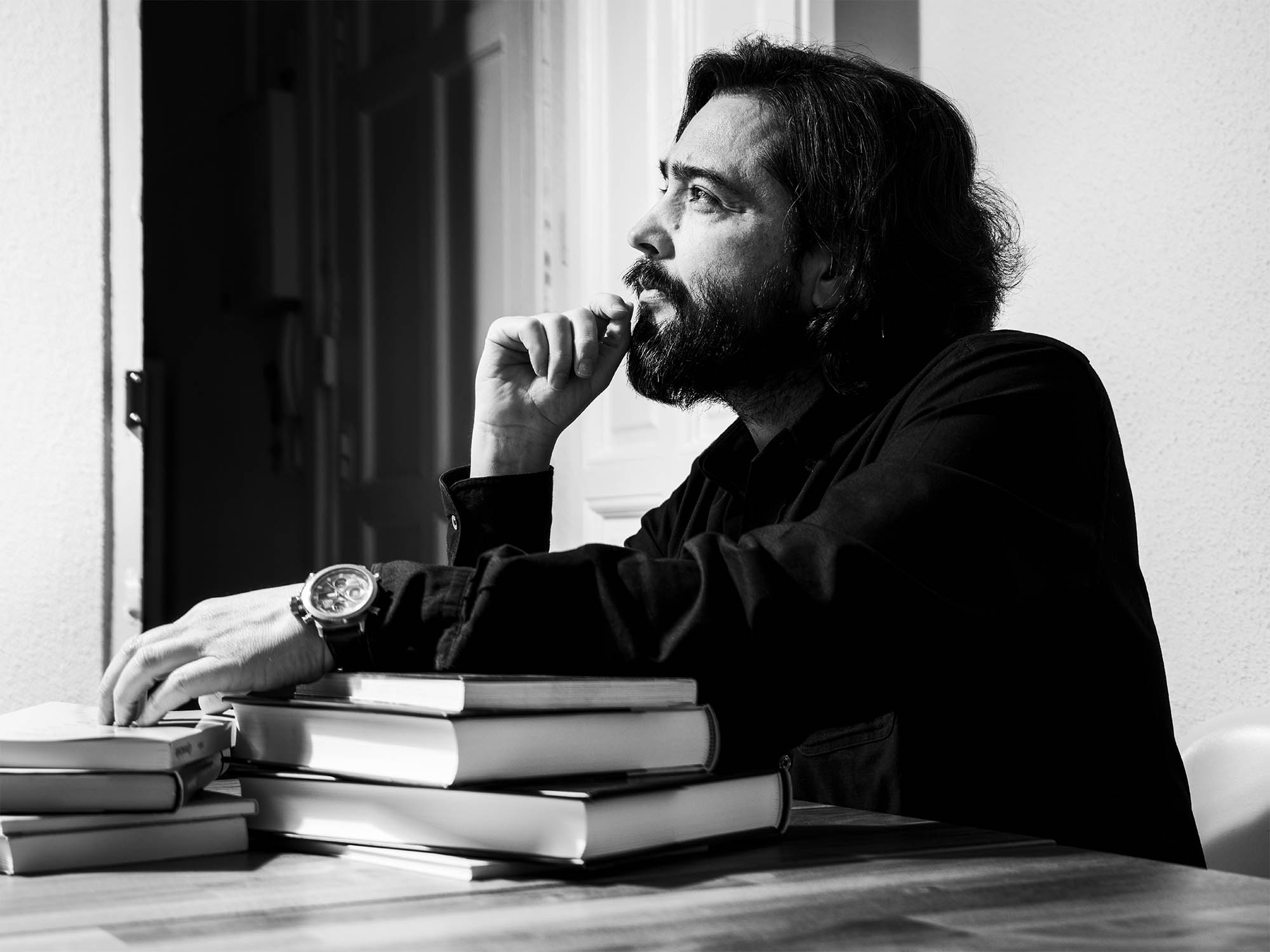

Daniel Innerarity (Bilbao, 1959) es de los pensadores que siempre va un paso por delante. Desde su perspectiva de catedrático de Filosofía política y social empezó a analizar el futuro de la democracia antes de que los medios se llenasen de artículos preguntándose por ese incierto devenir. Ahora, en Una teoría crítica de la inteligencia artificial (Galaxia Gutenberg) reflexiona sobre cómo la tecnología no solo está cambiando nuestros hábitos individuales sino a la vez nuestro comportamiento colectivo. Lo hace, como siempre, sin caer en discursos tremendistas, pero también sin el triunfalismo acrítico con que muchos aplauden la irrupción de la inteligencia artificial.

En el libro desmonta unos cuantos mitos. El primero es que los datos no son neutrales.

Estamos seducidos por la mera cantidad y hay muchos asuntos en la vida que se resuelven con cantidad, con tamaño. La tecnología de datos va a permitir cruzar millones de datos en diagnósticos médicos o tratamientos de enfermedades para obtener resultados y diagnósticos muy precisos. Pero cuando digo que los datos no son neutrales es porque han sido recogidos en un contexto y a veces son utilizados en otro contexto, lo cual plantea problemas.

En segundo lugar, los datos requieren interpretación. Yo propondría que nos planteáramos siempre si estamos ante un problema que podemos resolver con aumento de datos o un problema que tenemos que resolver mejorando la interpretación de la realidad. No hacemos más que hablar de Trump, cada día estamos recibiendo impactos de él y de sus decisiones, pero lo que realmente echo de menos es gente que me lo interprete bien. A veces incluso la profusión de datos te impide hacer una buena interpretación.

Eso también pasa con la información. Tener mucha información no significa tener buena información.

Exactamente.

En el libro señala que hay nuevas relaciones de poder que generan análisis de datos. ¿A qué nuevas relaciones de poder se refiere?

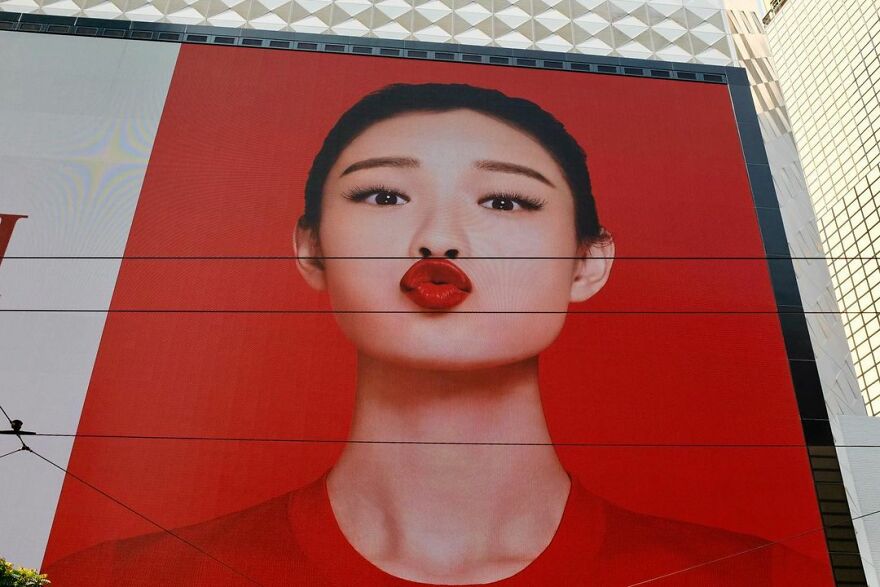

Hay ricos y pobres de datos en función de quién los tiene, quién tiene la capacidad de almacenarlos e interpretarlos. Un ejemplo, la mayor parte de las fotografías de caras que se han hecho en el mundo se han hecho a hombres blancos. Cuando diseñamos un mecanismo de reconocimiento visual, las fotos con las que se entrena son básicamente fotos de hombres blancos.

Eso significa que puede discriminar a los que no lo son.

Sí. Por ejemplo, le pusieron una foto de una mujer negra y dijo que era un chimpancé, lo cual es terrible. Tenemos que avanzar mucho en el entrenamiento de los algoritmos, pero sobre todo en que las bases, los datos con los que se entrenan esos algoritmos, sean lo más equitativos y diversos posibles.

¿Una gobernanza algorítmica, como la define usted, limita la democracia?

Depende. La gobernanza algorítmica tiene dos promesas que son muy buenas para la democracia, pero también limitadas. Una promesa de objetividad, es decir, en un momento en que nos quejamos de la extrema ideologización y de la polarización, reconducir ciertos debates a su dimensión más técnica, más objetiva, proporcionar más objetividad al discurso y a las narrativas políticas, disminuye el elemento sectario de la política. Pero no elimina la diferencia de opiniones, porque los humanos no nos rendimos ante una objetividad, sino que tenemos diferentes interpretaciones acerca de esa objetividad.

La otra promesa es la de la subjetividad, es decir, la promesa de que va a identificar mucho mejor nuestras preferencias y nuestros intereses. Lo cual es verdad, pero también es limitado, porque sabemos que muchas de nuestras preferencias son inducidas por el propio capitalismo que nos hace comprar cosas o generar necesidades que realmente no teníamos. Además, no es que nos identifique a nosotros como individuos, sino que lo hace en función de rasgos que compartimos con grupos de población a los que se supone que pertenecemos.

Hay ricos y pobres de datos en función de quién los tiene, quién tiene la capacidad de almacenarlos e interpretarlos.

Explica que la gran paradoja de la inteligencia artificial es que solo será general si reconoce sus límites. Y que únicamente podría sustituirnos si renuncia a hacerlo y opta por parecerse a nosotros. Ahora le pido una ucronía: ¿cree que puede acabar sustituyéndonos?

No, porque Deep Blue o AlphaGo nos ganan al ajedrez y al Go, que son juegos muy difíciles pero con unas reglas claras, en un tablero donde no se puede hacer cualquier cosa. Los humanos tenemos problemas que se parecen al ajedrez y al Go, o más sencillos, pero a la vez tenemos otros muchísimo más complicados.

Ahora que, por desgracia, estamos en un momento un poco prebélico o bélico sirve de ejemplo recordar cómo Churchill toma la decisión de ir a la guerra en lugar de firmar un armisticio con Hitler. Cuando todo el Partido Conservador y todos los datos de los expertos le estaban presionando para que no fuera a la guerra, él se fue al metro, hizo una pequeña encuesta y palpó la opinión que había. En Europa ahora tenemos que tomar cuatro o cinco grandes decisiones y hay que tomarlas en un tiempo relativamente rápido, con pocos datos, con mucha incertidumbre en relación con el futuro. No es una decisión de comer un alfil o mover una ficha negra, es una decisión de una enorme complejidad. Y en ese tema, la máquina que tiene fuerza computacional para gestionar datos nos va a ser de muy poca ayuda. Pregúntale al chat si hay que invertir más en armas en Europa, a ver qué te dice.

¿Le ha hecho la pregunta?

No, pero me imagino que intentará pensar qué es lo que yo quiero escuchar de él, lo cual no me interesa.

En general es bastante bondadoso en las opiniones.

Es un pelota, un cuñado pelota.

¿El error humano es más difícil de corregir que el de la inteligencia artificial?

No necesariamente. A veces los humanos somos más compasivos con los errores humanos y otras lo somos con los errores de las máquinas. Depende de las situaciones. A menudo el hecho de que el error lo haya cometido un procedimiento automático nos irrita todavía más y otras veces tendemos a disculparlo. No creo que haya una regla general. Lo que sí es importante tener en cuenta es que son errores de diferente naturaleza.

Daniel Kahneman lo identificó muy bien. Los humanos nos equivocamos siempre en cuatro o cinco cosas. No somos muy variados equivocándonos y lo interesante del asunto es que las máquinas hacen algo parecido pero de manera completamente diversa. Con lo cual la complementariedad es relativamente sencilla. Si cometieran los mismos errores que nosotros no tendríamos nada que hacer con ellas.

¿Puede poner un ejemplo?

Hay un montón de sesgos en los humanos que Kahneman estudió. Por ejemplo, solemos cometer un sesgo de confirmación. Pensamos que en la realidad lo percibimos todo y lo que tenemos una percepción muy selectiva hacia aquellas cosas que nos confirman lo que ya sabíamos.

¿Por qué el fenómeno de las redes sociales es tan inquietante? En buena medida porque uno termina con una adicción al azúcar, en este caso al azúcar de la confirmación que le vuelve obeso, incapaz de ver otras cosas que le llevan a la contraria. Por eso creo que una de las fuentes de racionalidad para los humanos es escuchar opiniones contrarias y estar en entornos diversos.

La dieta informativa variada que usted siempre recomienda.

Así es. Cuando un radiólogo mira una radiografía ve una cosa completamente distinta de lo que ve una máquina de reconocimiento visual. Un radiólogo no ve patrones, tiene una visión general y dificultad en identificar patrones. En cambio, las máquinas de reconocimiento visual lo que identifican muy bien son los patrones, pero no se hacen una idea general.

¿La inteligencia artificial aprende más rápido que nosotros?

Aprende de distintas maneras y distintas cosas. Aprende cuestiones que tienen que ver con su propia capacidad. Hay un ejemplo que pongo en el libro que es esa foto en la que Obama le está haciendo una broma a uno que se está pesando. Lo utilizo mucho en clase para hacer un experimento mental. Les pongo la foto y les digo que calculen el tiempo que han tardado en hacerse cargo de la situación. No mirar todos los detalles, simplemente que yo la pueda quitar y me cuenten qué es lo que ha pasado ahí. Tres, cuatro segundos.

Una máquina puede ser más precisa viendo, pero le tienes que explicar cantidad de cosas que los humanos ya sabemos. Hay que explicarle que a los humanos no nos gusta pesar más de lo que pesamos, por lo general. Se lo tengo que decir explícitamente. La riqueza del conocimiento humano es el conocimiento implícito.

¿En qué consiste humanizar la tecnología? Usted defiende que no implica solo incrementar el control sobre ella, sino acompañarla.

A los filósofos nos gusta molestar. Aprendí de Xavier Rubert de Ventós, que fue uno de mis maestros y amigo, que cuando había un linchamiento, lo moral era defender al linchado. Que luego se demostrará que era un violador o un asesino, pero en principio hay que defender al que está libre. Porque un linchamiento es una cosa brutal e inhumana. Ahora mismo hay un montón de tópicos y los filósofos tenemos un sesgo y es el de preguntarnos ‘¿y si eso no fuera exactamente así?’.

Un tópico muy habitual en los discursos sobre inteligencia artificial es el de que hay que humanizar la tecnología y que tiene que deber humanos en el proceso. Detrás de la automatización hay gente, a veces con trabajos mal pagados. Los instrumentos que tienen inteligencia artificial que usamos remiten a unas cadenas de suministro donde acabas llegando a una mina en un sitio siniestro, donde unos esclavos en medio de un conflicto bélico sacan litio. Por lo tanto, hay muchos humanos en el bucle.

El proceso de la inteligencia artificial tiene muchas fases, y en cada una de ellas los humanos tenemos que estar o no, muchos o pocos, y de una determinada manera. Comencemos por el principio. Las carreras de ciencias de la computación están muy masculinizadas y eso no puede salir bien. Tiene que haber diversidad, porque es una estrategia clave para ser razonable en cualquier cosa de la vida. Nos falta también diversidad en los datos. La mayor parte de los datos lo hemos generado las sociedades ricas, donde, por cierto, ha regido y rige todavía un machismo estructural, donde hay gente que ejerce dominación sobre otros, y eso se reflejará de alguna manera en los datos. Además hay un predominio del inglés. Por eso es interesante la idea de hacer una inteligencia artificial con el castellano y el resto de las lenguas oficiales del Estado.

La tecnología hoy en día nos está privando de puntos de vista alternativos, y es algo que vamos a pagar caro. Probablemente, eso tenga algo que ver con la situación de hipercalentamiento que vivimos en el mundo de la política actual.

Considera que es un error pensar que la ética de la tecnología es una especie de guardiana de los límites. Entonces, ¿cómo podemos ejercer o aplicar una ética desde esta visión crítica?

A mí me interesaba más la política que la ética, y de hecho, este libro tiene su origen en un informe que me encargó la UNESCO, después de haber hecho un informe sobre la ética de la inteligencia artificial, y la secretaria general, consciente de que faltaba una parte, me propuso hacer la política de la inteligencia artificial. Me gusta más ese punto de vista por varias razones, pero una de ellas es porque cierta manera de hacer la ética tiende a establecer prohibiciones, líneas rojas, fronteras. La gran cuestión es cómo conseguimos que haya control de la tecnología, pero al mismo tiempo le dejemos a la tecnología un cierto desarrollo autónomo, sin el cual arruinaríamos su performatividad.

Estoy obsesionado con la idea de control democrático. Hay que ejercer un cierto tipo de control, pero el control, tal y como lo hemos entendido, ya no vale, no funciona. El control jerárquico sobre poblaciones, la monitorización directa sobre nuestros gobernantes, el control de la tecnología casi mecánico no funciona. Tenemos que ir a espacios de autocontrol guiado. No soy un liberal, tiene que haber intervenciones en la sociedad, pero no confío mucho en el gobierno entendido como control de cada uno de los pasos porque eso no suele producir nada nuevo y arruina la inteligencia de la sociedad.

Esto pasa todavía más con una tecnología tan sofisticada como esta. Pretender que sobre cada uno de los pasos haya un control, que no haya nada de riesgo en una tecnología que se define porque aprende, es como pensar que vamos a educar a nuestros hijos para seguirles dando instrucciones en todos los momentos de desarrollo de su vida y resolviendo sus dilemas éticos, cosa que no hacemos.

Lo que pasa es que nos encontramos con que hay un poder, el tecnológico, que ha demostrado que puede superar los límites de los gobernantes. ¿Quién controla a estas plataformas?

Hay un gap temporal entre la velocidad del desarrollo de la tecnología y la lentitud de nuestros procedimientos burocráticos, estatales, deliberativos, parlamentarios. Hace 300 años podíamos vivir con la ficción de que el proceso de cambio social y tecnológico podía ser equilibrado, acompasado o frenado por las instituciones parlamentarias. Las discusiones del parlamento iban a la misma velocidad que el desarrollo tecnológico. Eso ya no funciona.

Aquellos que hoy en día abogan por el aceleracionismo o el tecnosolucionismo van a tanta velocidad porque se ahorran dos procesos que llevan mucho tiempo. El de la inclusión, es decir, la toma en consideración de los intereses de todos los afectados con una decisión. El otro ahorro es de tiempo y de pensar que ellos no se van a preocupar por el impacto que sus decisiones van a tener en el medioambiente, que es otro engorro. ¿Qué conquista es esa que consiste en haber llegado muy rápido a un sitio despolitizado y probablemente insostenible?

Les tenemos que ganar la batalla mostrando que su rapidez es ilusoria, excluyente e insostenible. Y que nuestra aparente lentitud, como consecuencia de la deliberación, de la medición de impactos, en el fondo es una ganancia de tiempo.

Pero viendo como van las cosas en esa batalla, hay quien cree que lo de la rapidez y menos democracia que plantea gente como Elon Musk no está tan mal. Y muchos son jóvenes.

Podríamos ponerles delante de algún espejo que no les resulta muy favorable. Por ejemplo, el de la sostenibilidad del planeta. Los demócratas tenemos razón porque queremos tener una escala de temporalidad más amplia que el instante de gratificación inmediato en el que se mueven los aceleracionistas. También tenemos un sentido de responsabilidad por el planeta que estos hace mucho tiempo que han dado por perdida.

¿Cómo podemos concienciarnos más sobre la necesidad de preservar nuestra privacidad? Sabemos que estamos regalando información sin control y a veces parece que nos da igual.

Soy bastante comprensivo con ese ciudadano al que le da igual porque le estamos sobrecargando. No puede ser que las decisiones acerca de la intimidad, privacidad, los datos propios, descansen tanto sobre las espaldas de gente que sabemos muy poco de esto. Confío mucho más en que haya instituciones de auditoría, de vigilancia que me resulten fiables que en este esquema tan ultraliberal de individuos que se relacionan directamente con la plataforma.

Sin intermediarios.

Es un esquema muy dominante en la sociedad actual y además resulta muy atractivo para la gente joven. El mundo está a nuestra disposición, en términos cognitivos y en términos de libertad, y tú decides el grado de intimidad y exposición que quieres tolerar. Todo está en Google, no nos hacen falta los periodistas, los médicos, los profesores, los sacerdotes, los sindicalistas, los políticos... Ese es un mundo terrible en el que yo solo puedo ejercer mi soberanía de manera ficticia.

¿Qué resultado tiene ese ultraliberalismo? Un individuo absolutamente sobrecargado. Además, el nivel de exposición que uno considera aceptable condiciona el nivel de exposición general, porque hay muchos datos míos que permiten deducir datos de otros que se me parecen. Con lo cual, al final, yo que nunca he sido comunista, estoy pensando que hay que ir a una expropiación general de los datos. Es decir, hay que tratar los datos y la privacidad como un bien público.

Hay que ir a una expropiación general de los datos y tratar la privacidad como un bien público

En el colegio de mi hijo utilizan Google, pero nadie nos preguntó si estábamos de acuerdo.

Cuando hay otros buscadores distintos. Antes hablábamos de control y a mí me parece que la manera más humana de controlar es la construcción de confianza. Imagínate que tú tienes que estar controlando continuamente a todas las personas con las que te relacionas. La confianza, decía Luhmann, es reductor de la complejidad. Y vivimos en un mundo de una complejidad que nos resulta inmanejable. Entonces, establezcamos procedimientos, relaciones, instituciones confiables. Así se nos reducirá esto a una medida aceptable.

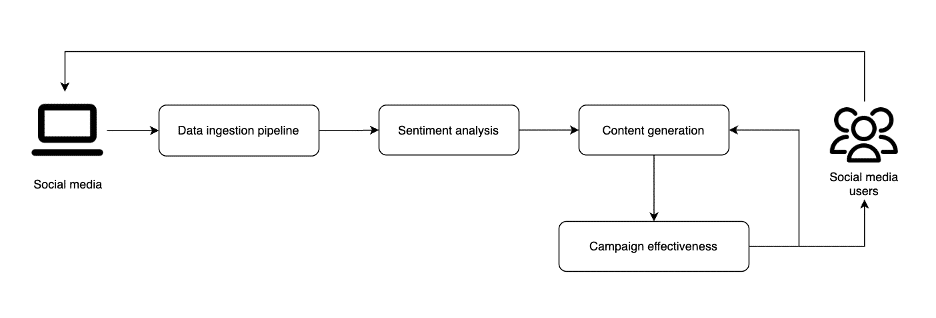

El trabajo humano hace progresar a la inteligencia artificial. Y nosotros los periodistas lo vemos, por ejemplo, en las transcripciones o en las traducciones. Pero también en el día a día, con instrumentos como el GPS. Es decir, podemos hacer que la IA funcione mejor.

Sabiendo que siempre se paga un pequeño precio con ello, ¿no? Los taxistas de París utilizan masivamente el GPS. Los de Londres muy poco. ¿Cuál es la diferencia? Una persona que utiliza el GPS, yo lo utilizo para la montaña, termina desentrenando una cierta habilidad que en momentos de riesgo nos viene bien.

Me gusta mucho la aviación, porque mi padre era ingeniero aeronáutico y me inculcó esa afición. La automatización del pilotaje de aviones ha llevado a unos pilotos que manejan unos ordenadores muy expertos y que, como esos ordenadores se caigan en algún momento, no saben qué hacer. En Sully, la película de Tom Hanks, se cuenta la historia de un piloto que tiene un problema con un avión, con un motor, y el sistema le dice que puede llegar al aeropuerto sin problemas. Y él no cree el sistema. Ameriza, salva la vida de todos, lo hace muy bien, pero va a juicio, por haber puesto en riesgo la vida de mucha gente. Gana el juicio. Pero la gran cuestión es ¿por qué él ameriza? Porque había sido piloto de caza, una persona entrenada a pilotar en condiciones de incertidumbre. ¿Qué ha pasado en la aviación en estos últimos años? En la formación de los pilotos se ha incluido mucho más el componente de riesgo, de pilotar en circunstancias extraordinarias, que se había perdido por la automatización.

La conclusión del libro es que lo que tenemos que entender es que tecnología y sociedad están vinculadas, y a partir de ahí hacerlo lo mejor posible. ¿Es optimista?

Soy optimista en el sentido de que esto no es un combate entre humanos versus máquinas. Esto es una batalla entre humanos que utilizan máquinas contra humanos que utilizan máquinas. A mí no me preocupa que la inteligencia artificial nos supere en inteligencia a los humanos. Lo que me preocupa es que un chino la utilice para controlar a la población, o que un americano la utilice sin tener en cuenta su impacto medioambiental. Pero la culpa no es de la tecnología, es de los humanos que la usamos mal.

Que es lo que está pasando en algunos casos.

Lamentablemente, sí.

![Viajes National Geographic 2018 [Año Completo]](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEgSbdmMkLJowiHX0D7ZFObOuFNmO_BC-d4TBPocZaO-1H377MsRi8qXfEjnyg1aUn1HxLWIWXR7CHxNwjEcExQZg8c9rDT1Q6_V8m83oz5IrKmgVBZ5WJ8hpSDWqin70s-9CychBPdbg5_Fjfby27JNxbfXvvWfS9dmYU6C3KZ4xyyBQ0v7I2xVAiQYoogH/s888/viajes-national-geographic-2018-ano-completo-freelibros.png)

![“[…] Querer morir es chunguísimo”. ¡Mártir! de Kaveh Akbar](https://lapiedradesisifo.com/wp-content/uploads/2025/05/martir-sobrecubierta-min.png)