Cómo ejecutar Qwen 2.5 en chips de IA de AWS utilizando bibliotecas de Hugging Face

En un avance significativo en el campo de los modelos de lenguaje, la introducción de los modelos Qwen 2.5 marca […]

En un avance significativo en el campo de los modelos de lenguaje, la introducción de los modelos Qwen 2.5 marca un hito en el desarrollo de inteligencia artificial. Estas innovadoras herramientas consisten en una colección de modelos generativos preentrenados y diseñados para seguir instrucciones con una flexibilidad sin precedentes, abarcando configuraciones que oscilan entre 0.5 mil millones y 72 mil millones de parámetros. Su diseño está orientado a mejorar los casos de uso en diálogos multilingües, superando tanto a sus predecesores como a muchos modelos de chat disponibles en el mercado, conforme a los estándares de la industria.

La arquitectura en la que se basan estos modelos es un modelo de lenguaje autorregresivo, utilizando una estructura de transformador optimizada. Esto permite atender eficientemente a 29 idiomas, además de mejorar la interpretación de roles y el establecimiento de condiciones, lo que los hace altamente prácticos para el desarrollo de chatbots sofisticados.

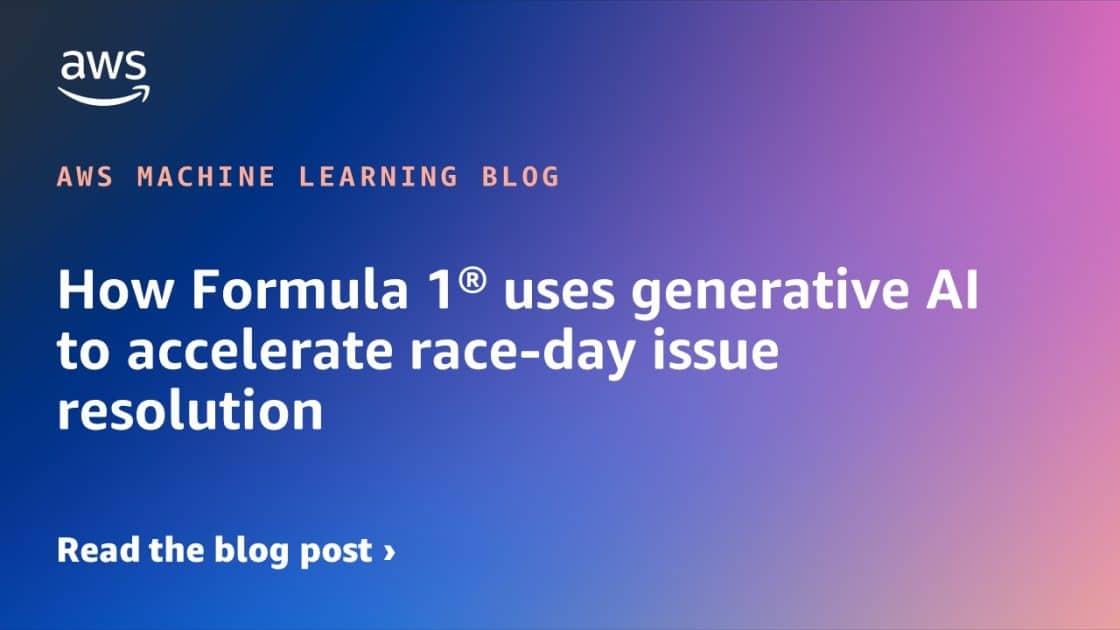

Para facilitar la implementación de los modelos Qwen 2.5, se han creado guías detalladas para desplegarlos utilizando las capacidades de Inferentia en Amazon Elastic Compute Cloud (Amazon EC2) y Amazon SageMaker. Estas guías emplean la herramienta Text Generation Inference (TGI) de Hugging Face y la biblioteca Optimum Neuron, que actúa como una interfaz entre la biblioteca Transformers y los aceleradores Inferentia y Trainium de AWS.

Los usuarios pueden optar por implementar los modelos en instancias EC2 inf2 o en SageMaker. En el caso de EC2, se recomienda conectarse a la instancia mediante SSH y crear archivos de configuración para definir constantes y parámetros de entorno, asegurando así que el modelo opere de manera óptima. Por otro lado, SageMaker ofrece una implementación más expedita directamente desde su consola de gestión.

Ambas opciones incluyen pasos para verificar el correcto funcionamiento del modelo, permitiendo incluso enviar solicitudes de prueba en varios idiomas para verificar su capacidad multilingüe. Esto representa un avance sustancial para las empresas que emplean IA, promoviendo una integración más fluida y eficiente con mejor capacidad de respuesta y comprensión.

Es crucial que las empresas recuerden terminar el uso de estas instancias y servicios para evitar costos adicionales. AWS proporciona documentación extensa para ayudar a los usuarios a gestionar estos recursos y realizar implementaciones efectivas con estos avanzados modelos.

Con Qwen 2.5, se abre un nuevo horizonte para el desarrollo de aplicaciones de inteligencia artificial, especialmente en entornos multilingües y diálogos complejos, contribuyendo significativamente al avance en el procesamiento del lenguaje natural en la tecnología contemporánea.

![Vuelos (Baratos) a Mánchester desde España [SOLO ¡36€!]](https://cdn.guialowcost.es/wp-content/uploads/Manchester-Town_800x450.jpg)

-U48348753120CAm-1024x512@diario_abc.jpg)