Krasse Links No 51

Willkommen zu Krasse Links No 51. Werft den „Bag of Heuristics“ in den Datenpool, heute overfitten wir Brandolinis Lawfare im Latent Space. Der Branchen-Newsletter Semianalysis berichtet, dass Microsoft nicht nur einen Großteil der geleasten Datacenter gekündigt hat (wir berichteten), sondern … Weiterlesen →

Willkommen zu Krasse Links No 51. Werft den „Bag of Heuristics“ in den Datenpool, heute overfitten wir Brandolinis Lawfare im Latent Space.

Der Branchen-Newsletter Semianalysis berichtet, dass Microsoft nicht nur einen Großteil der geleasten Datacenter gekündigt hat (wir berichteten), sondern auch der Bau der eigenen groß angepriesenen Data-Center heimlich massiv ausgebremst.

While the leasing slowdown is material, these changes are not material to the short and medium term and only impact 2027+. The more important slowdown of Microsoft’s changes to their self-build datacenter plans. Our research indicates that Microsoft is freezing 1.5GW of near term self-build datacenter projects – projects that were previously scheduled to go online in 2025 and 2026.

Microsoft is freezing multiple (but not all) self-build projects across the globe with an immediate impact on capacity for 2025 and 2026 – as highlighted earlier to our Datacenter Model clients. Numerous multi-hundred-MW Microsoft campuses have shown underwhelming progress, despite our research indicating that these projects have secured energy and all necessary approvals. This is a deliberate move by Microsoft to slow the expansion of its self-built capacity.

Während Eric Schmidt dafür lobbyiert, dass wir 99% unserer Ressourcen für die vage Hoffnung auf AGI anzünden sollen, zieht sich Microsoft zurück und 80% der Data Center in China stehen still.

Diese Blase ist weird.

Im Atlantic denken Ian Bogost und Charlie Warzel darüber nach, was DOGE mit all den Regierunsdaten anstellt, die es aus all den Behörden klaut und in einem großen Datenpool sammelt.

The IRS gathers comprehensive financial and employment information from every taxpayer; the Department of Labor maintains the National Farmworker Jobs Program (NFJP) system, which collects the personal information of many workers; the Department of Homeland Security amasses data about the movements of every person who travels by air commercially or crosses the nation’s borders; the Drug Enforcement Administration tracks license plates scanned on American roads. And that’s only a minuscule sampling. More obscure agencies, such as the recently gutted Consumer Financial Protection Bureau, keep records of corporate trade secrets, credit reports, mortgage information, and other sensitive data, including lists of people who have fallen on financial hardship. […]

Since Donald Trump’s second inauguration, Elon Musk and the Department of Government Efficiency have systematically gained access to sensitive data across the federal government, and in ways that people in several agencies have described to us as both dangerous and disturbing. Despite DOGE’s stated mission, little efficiency seems to have been achieved. Now a new phase of Trump’s project is under way: Not only are individual agencies being breached, but the information they hold is being pooled together. The question is Why? And what does the administration intend to do with it?

All die Daten sollen natürlich auch mit LLMs ausgewertet und operationalisierbar gemacht werden.

Advancements in artificial intelligence promise to turn this unwieldy mass of data and metadata into something easily searchable, politically weaponizable, and maybe even profitable. DOGE is reportedly attempting to build a “master database” of immigrant data to aid in deportations; NIH Director Jay Bhattacharya has floated the possibility of an autism registry (though the administration quickly walked it back). America already has all the technology it needs to build a draconian surveillance society—the conditions for such a dystopia have been falling into place slowly over time, waiting for the right authoritarian to come along and use it to crack down on American privacy and freedom.

Damit lässt sich dann prima eine automatisierte Vorwurf-Pipline gegen Migrant*innen oder politische Gegner konstruieren.

Maybe you have information from background checks or health studies that allows you to punish people who have seen a therapist for mental illness. Or to terminate certain public benefits to anybody who has ever shown income above a particular threshold, claiming that they obviously don’t need public benefits because they once made a high salary. A pool of government data is especially powerful when combined with private-sector data, such as extremely comprehensive mobile-phone geolocation data. These actors could make inferences about actions, activities, or associates of almost anybody perceived as a government critic or dissident. These instances are hypothetical, but the government’s current use of combined data in service of deportations—and its refusal to offer credible evidence of wrongdoing for some of those deported—suggests that the administration is willing to use these data for its political aims. […]

It could, for example, target for harassment people who deducted charitable contributions to the Palestine Children’s Relief Fund, drove or parked near mosques, and bought Halal-certified shampoos. It could intimidate citizens who reported income from Trump-antagonistic competitors or visited queer pornography websites. It could identify people who have traveled to Ukraine and also rely on prescription insulin, and then lean on insurance companies to deny their claims.

Und dafür müssen die Vorwürfe auch gar nicht wahr sein.

But even worse than a mirror of this particular flavor of authoritarianism is the possibility that it might never even need to be well built or accurate. These systems do not need to work properly to cause harm. Poorly combined data or hasty analysis by AI systems could upend the lives of people the government didn’t even mean to target.

Hier meine Prognose: LLMs werden Listen mit politischen Gegnern abarbeiten, für die sie im riesigen DOGE-Datenpool „vorwerfbare“ Datenpunkte finden, für die sie in einem zweiten Schritt Schriftsätze formulieren (Anklage/Abmahnung/Anzeige/Abschiebesantrag), mit denen die Menschen in einem dritten Schritt terrorisiert werden. Quasi „Brandolinis Lawfare“ (Sven Kloppenburg)

Natürlich wird das über die Zeit das Vertrauen in staatliche Institutionen, Prozesse und Gesetze vollkommen zerstören. Willkommen im Zeitalter des Rauschens.

Georg Restle hat für die ARD eine sehr sehenswerte Doku über die zur Wahl ochestrierte Migrationspanik gemacht.

Ben Smith deckt bei Semafor einen ganzen Wust an rechten Chatgruppen auf, in denen Tech-Oligarchen seit der Pandemie mit rechten bis mittextremistischen Anti-Woke Publizistikgrößen rumhängen und sich wechselseitig radikalisierten.

And it was just another day in Chatham House, a giant and raucous Signal group that forms part of the sprawling network of influential private chats that began during the fervid early days of the COVID-19 pandemic, and which have fueled a new alliance of tech and the US right. That same week in Chatham House, Lonsdale and the Democratic billionaire Mark Cuban sparred over affirmative action, and Cuban and Daily Wire founder Ben Shapiro discussed questions of culture and work ethic.[…]

their influence flows through X, Substack, and podcasts, and constitutes a kind of dark matter of American politics and media. The group chats aren’t always primarily a political space, but they are the single most important place in which a stunning realignment toward Donald Trump was shaped and negotiated, and an alliance between Silicon Valley and the new right formed. The group chats are “the memetic upstream of mainstream opinion,” wrote one of their key organizers, Sriram Krishnan, a former partner in the venture capital firm Andreessen Horowitz (typically styled a16z) who is now the White House senior policy adviser for AI.

Geheime Gruppenchats mächtiger Männern bleiben die größte Gefahr, die von Social Media für die Demokratie ausgeht.

Vielen dank, dass Du Krasse Links liest. Da steckt eine Menge Arbeit drin und bislang ist das alles noch nicht nachhaltig finanziert. Diesen Monat komme ich immerhin auf € 345,71- von den angestrebten 1.500,-. Mit einem monatlichen Dauerauftrag kannst Du helfen, die Zukunft des Newsletters zu sichern. Genaueres hier.

Michael Seemann

IBAN: DE58251900010171043500

BIC: VOHADE2H

Christopher Mims berichtet im Wallstreet Journal, dass sich immer mehr ernsthafte KI-Forscher*innen mit der These vom Stochastischen Papagei abfinden.

In a series of recent essays, Mitchell argued that a growing body of work shows that it seems possible models develop gigantic “bags of heuristics,” rather than create more efficient mental models of situations and then reasoning through the tasks at hand. (“Heuristic” is a fancy word for a problem-solving shortcut.)

Mir gefällt „Bag of Heuristics“, aber es ist wichtig zu verstehen, dass wir es erstens nicht von menschlich formalisier- und verstehbaren Heuristiken zu tun haben, sondern mit semantischen Makrostrukzturen, die durchaus komplexe, semantische Operationen ermöglichen. Und zweitens, dass dieser „Bag“ unvorstellbar groß ist: In Hunderten von Milliarden von Parametern lassen sich im Zweifel für alle Eventualitäten eines Problems alle Lösungspfade speichern. Oder 89 %, reicht auch.

This research also suggests why many models are so massive: They have to memorize an endless list of rules of thumb, and can’t compress that knowledge into a mental model like a person can. It might also help explain why they have to learn on such enormous amounts of data, where a person can pick something up after just a few trials: To derive all those individual rules of thumb, they have to see every possible combination of words, images, game-board positions and the like. And to really train them well, they need to see those combinations over and over.

Wenn man LLMs verstehen will, muss man sich von dem Gedanken lösen, dass sie ein Modell des Gehirns sind, oder des „Minds“ oder gar ein „Weltmodell“.

LLMs sind ein Modell unserer Erwartungen.

Dass LLMs semantisch korrekte Sätze formen können, bedeutet, entweder, dass LLMs „verstehen“ (darauf fallen die KI-Bros rein), oder dass Semantik in der Sprache codiert ist und nicht, wie viele bislang glaubten, in der Intention des Sprechers oder der Interpretation des Hörers.

Wenn wir die erste Hypothese ausschließen, dann sind LLMs der materielle Beweis der poststrukturalistischen These, dass Zeichen immer nur auf sich selbst verweisen. Die Sprache spricht uns, nicht wir die Sprache.

Während ich das hier tippe, wäge ich mit jedem Wort ab, welche Assoziationen, Verbindungen, Erlebnisse, Wissen und Emotionen ich bei Euch erwarten kann, wenn ich mir vorstelle, wie ihr das lest. Jedes Wort erfordert eine Bezugnahme auf einen erwarteten Semantischen Raum. In diesem Bezugnehmen fließen meine Erwartungen an Eure Erwartungen in den Text ein.

Was LLMs in Wirklichkeit tun, ist von diesen eingebetteten Erwartungserwartungen (Luhmann) in ihrem Training einen unterdimensionierten Abdruck zu nehmen („Latent Space„), den sie als Landkarte zur Navigation desselben Semantischen Raums verwenden, den auch wir bewohnen. Ihre „Intelligenz“ ist nur das Orientierungswissen in diesem Raum.

Mit dieser Erkenntnis können wir auch alle anderen Machinelearning-Ansätze entzaubern:

Machine Learning ist keine „Künstliche Intelligenz“, sondern immer nur die Aneignung eines lokalen Orientierungswissens einer konkreten Umwelt. Ein Orientierungswissen das mit sehr „hungrigen“ Algorithmen in einer Art Tree-Search ertastet wird.

Man muss Machine Learning-Anwendungen von ihren Umwelten her denken.

Die Umwelt von AlphaGo ist Go. Die Maschine lernt in dieser Umwelt gewinnende Pfade zu finden. Die Umwelt von AlphaFold ist der Interaktionsraum von sich verbindenden Aminosäuren und es lernt dort relevante Protein-Faltungs-Pfade zu entdecken. Die Umwelt der LLMs sind Semantiken und sie lernen drain plausible Pfade zu finden.

In allen Fällen führt das durchaus dazu, dass innerhalb des Gesagten neue plausible, relevante, manchmal sogar nützliche Pfade gefunden werden können, aber LLMs können eines nie: Pfade abseits unserer Erwartungen zu finden.

LLMs sind semantische Spiegel und KI-Bros ihre Cyber-Narzisten.

Associated Press berichtet über Vorladungen, die die Trump-Regierung und der Congress an große KI Firmen geschickt haben.

In the White House and the Republican-led Congress, “woke AI” has replaced harmful algorithmic discrimination as a problem that needs fixing. Past efforts to “advance equity” in AI development and curb the production of “harmful and biased outputs” are a target of investigation, according to subpoenas sent to Amazon, Google, Meta, Microsoft, OpenAI and 10 other tech companies last month by the House Judiciary Committee.

And the standard-setting branch of the U.S. Commerce Department has deleted mentions of AI fairness, safety and “responsible AI” in its appeal for collaboration with outside researchers. It is instead instructing scientists to focus on “reducing ideological bias” in a way that will “enable human flourishing and economic competitiveness,” according to a copy of the document obtained by The Associated Press.

Dabei geht es nicht in erster Linie um generative KI, sondern um alle Arten und Weisen, wie KI-Firmen versuchen, gegen Biases in Machine Learning Systemen zu vorzugehen. Das gilt auch z.B. für Bilderkennungsalgorithmen, die Schwierigkeiten haben, schwarze oder asiatische Menschen zu erkennen.

One study showed self-driving car technology has a hard time detecting darker-skinned pedestrians, putting them in greater danger of getting run over. Another study asking popular AI text-to-image generators to make a picture of a surgeon found they produced a white man about 98% percent of the time, far higher than the real proportions even in a heavily male-dominated field.[…]

Face-matching software for unlocking phones misidentified Asian faces. Police in U.S. cities wrongfully arrested Black men based on false face recognition matches. And a decade ago, Google’s own photos app sorted a picture of two Black people into a category labeled as “gorillas.”

Diese Art von Forschung ist der Trumpregierung in Dorn im Auge, denn sie hat ja recht, dass es sich da sehr wortwörtlich um „DEI-Maßnamen“ handelt: Eine materiell festgestellte Ungleichbehandlung wird versucht, durch gezielte andere Ungleichbehandlungen auszugleichen. Das ist wichtig und gut (wie andere DEI-Maßnahmen auch), aber kann auch mal schlecht umgesetzt sein?

So versorgte Googles mißlungener Versuch, den Bias seiner Bildgenerierungs-KI durch ausgleichende Systemprompts zu korrigieren, die Rechte mit ihrem GoTo-Beispiel für „woke AI“.

Google tried to place technical guardrails to reduce those disparities before rolling out Gemini’s AI image generator just over a year ago. It ended up overcompensating for the bias, placing people of color and women in inaccurate historical settings, such as answering a request for American founding fathers with images of men in 18th century attire who appeared to be Black, Asian and Native American. Google quickly apologized and temporarily pulled the plug on the feature, but the outrage became a rallying cry taken up by the political right.

KI ist längst die relevanteste Arena des Kulturkampfes und es wird spannend sein, zu sehen, wie die Tech-Unternehmen sich in diesem Konflikt positionieren. Denn klar ist, dass die Biases ja eine nachgewiesene Realität sind und zu materiell schlechteren Produkten führen. Werden die Techbros ihre eigenen Produkte kaputtmachen, um dem neuen Zeitgeist zu entsprechen?

Aber das ist nur der Anfang. Das alles passiert, während Elon Musk verzweifelt versucht, seinem Grok die Wokeness aus dem „Latent Space“ zu prügeln. Das ist lustig anzusehen, klar, aber dahinter steht der Wunsch nach Kontrolle und am Ende wird Musk erfolgreich sein.

LLMs sind, wenn sie massenhaft eingesetzt werden, Massensprach-Akt-Waffen. Sie können dafür eingesetzt werden auf subtile Art Frames, Sprachregelungen und Narrative zu normalisieren oder gar zu hegemonialisieren. Je besser es den Unternehmen gelingt, den Output der Systeme zu kontrollieren, desto größeren Einfluss bekommen sie über unsere gesellschaftlichen Semantiken.

Trump macht den ersten Schritt zur Gleichschaltung der Sprach-Akt-Waffen.

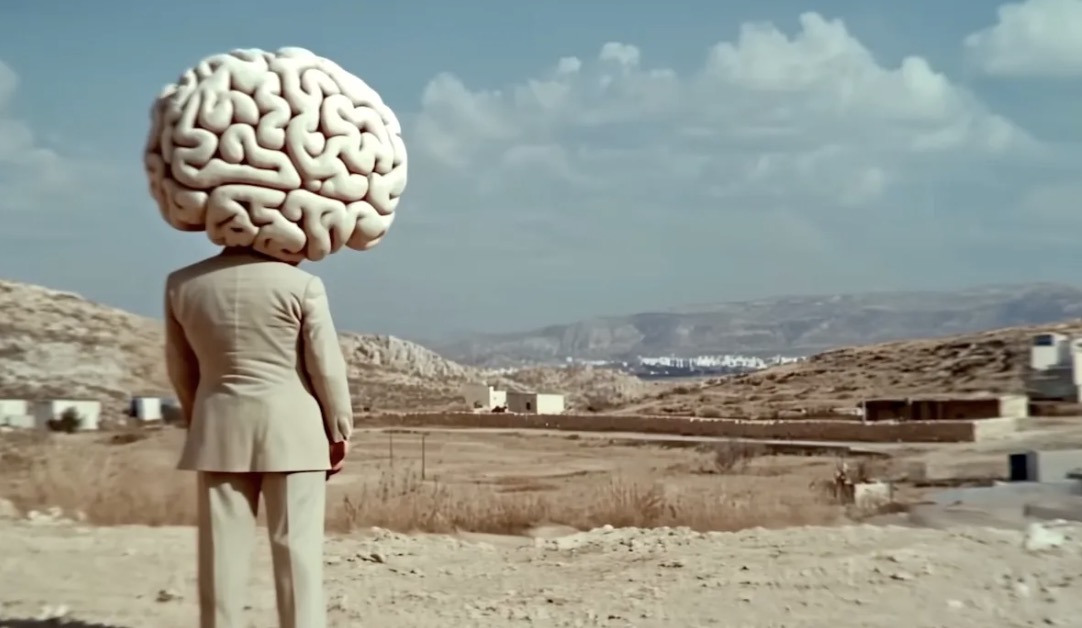

Der Bild- und Medienwissenschaftler Roland Meyer hat in der FAZ eine umfassende Analyse der feindlichen Übernahme der Bildkultur durch den digitalen Faschismus in Gestalt des KI-Slop abgeliefert.

Bildgenerierungs KIs sind auch nur LLMs für optische Semantiken. Bildliche Ausdrucksformen, sogar so herausgehoben raffinierte, wie die von Studio Ghibli, werden ebenfalls als makrosemantische Templates im „Bag of Heuristics“ abgelegt.

Bilder sind genauso wie Texte teil unseres gemeinsamen kulturellen Orientierungsrahmens und so wurden eben auch all die Arrangements, Perspektiven und Konditionierungen unserer Sehgewohnheiten in den Transformer-Schredder gedrückt, um unsere visuellen Erwartungen zu reproduzieren. Dass dabei vor allem konservative Semantiken herausfallen, die hoch Anschlussfähig an das Imaginäre der Rechten sind, sollte nicht überraschen.

KI-Bildgeneratoren bieten sich für solche Mash-ups der historischen Zeitschichten geradezu an. Unterschiedslos behandeln sie die Gesamtheit der visuellen Überlieferung als Reservoir beliebig rekombinierbarer visueller Muster. Zugleich verdichten sich in den KI-Bildwelten die visuellen Klischees unserer digitalen Kultur, die von den Filterästhetiken und Empfehlungsalgorithmen der Onlineplattformen beherrscht wird. Die synthetischen Vergangenheiten erscheinen so für die digitale Gegenwart immer schon ästhetisch optimiert, unwirklich glänzend und von strahlender Glätte, zugleich nostalgisch und klischeebeladen. Nicht von ungefähr ist die Ästhetik generativer KI, wie der Journalist Gareth Watkins und andere angesichts der anhaltenden Flut KI-generierter Memes konstatiert haben, zur bevorzugten visuellen Propagandasprache des digitalen Faschismus avanciert. Nicht nur Elon Musk, auch Donald Trump und Javier Milei teilen am liebsten KI-generierte Bilder ihrer selbst, die sie in heroischen Posen und strahlender Männlichkeit präsentieren.

Die KI-Faszination der globalen Rechten ist aber nicht nur eine ästhetische. Vielmehr deutet sich in ihr eine ideologische Affinität an, auf der auch das politische Bündnis von Techoligarchie und autoritärer Staatsmacht basiert. Der Weg der KI-Entwicklung, den Open AI, Meta und andere eingeschlagen haben, folgt einer Logik der schrankenlosen Expansion, der Erschließung immer neuer Datenressourcen und des Aufbaus immer größerer Rechenkapazitäten in Form von riesigen Datenzentren, von denen jedes einzelne den Stromverbrauch einer ganzen Großstadt aufweist. Für diese Pläne ist man auf politische Unterstützung angewiesen – und, umgekehrt, entspricht dieser Expansionskurs den Ambitionen Trumps und anderer, globale Geopolitik explizit als Kampf aller gegen alle zu betreiben. Sehr unmissverständlich warnte in diesem Sinne J.D. Vance beim jüngsten KI-Gipfel AI Summit in Paris Europa davor, durch etwaige Regulierungsbemühungen die amerikanische KI-Vorherrschaft zu gefährden, und nannte KI die „new frontier“ – was zugleich amerikanische Siedlermythen wie die Erinnerung an das Weltraumprogramm der Kennedy-Ära aufrufen sollte.[…]

Das wohl prominenteste Network-State-Projekt namens „Praxis“ wirbt auf seiner Website unter dem Slogan „Reclaim the West“, den Westen zurückerobern, mit offensichtlich KI-generierten Bildern, in denen gotische Kathedralen, Sechzigerjahre-Space-Age-Design und Computerspiel-Ästhetik zu archäofuturistischen Stadtvisionen verschmelzen. Es sind neokoloniale Traumbilder „westlicher Zivilisation“, generiert aus den visuellen Mustern der Vergangenheit und präsentiert als technologiegetriebene Zukunftsvision.

Als „ästhetische Rechtfertigung des Rechts des Stärkeren“ hat der Kulturwissenschaftler Wolfgang Ullrich kürzlich die neuen autoritären Bildwelten charakterisiert. Die Formel bringt auf den Punkt, was die reaktionären Visionen der Network-States mit den hypermaskulinen Antikenphantasien von Musk und Zuckerberg, Altmans kulleräugigem Profilbild und der „ghiblifizierten“ Meme-Propaganda des Weißen Hauses verbindet: Es sind Bildwelten der Rücksichtslosigkeit, in denen neokoloniale Expansionsträume, pseudohistorisch bemäntelte Machtphantasien, ein entfesselter Datenextraktivismus und die zynische Glorifizierung staatlicher Gewalt ihren gemeinsamen Ausdruck finden.

Die Bildsprach-Akt-Waffen sind längst im Dauerbetrieb an der Informations-Front.

Techcrunch über die weirde Tatsache, dass die neusten Flagshipmodelle von OpenAI – o3 und o4-mini deutlich mehr „haluzinieren“ als die Vorgänger.

OpenAI found that o3 hallucinated in response to 33% of questions on PersonQA, the company’s in-house benchmark for measuring the accuracy of a model’s knowledge about people. That’s roughly double the hallucination rate of OpenAI’s previous reasoning models, o1 and o3-mini, which scored 16% and 14.8%, respectively. O4-mini did even worse on PersonQA — hallucinating 48% of the time.

Third-party testing by Transluce, a nonprofit AI research lab, also found evidence that o3 has a tendency to make up actions it took in the process of arriving at answers. In one example, Transluce observed o3 claiming that it ran code on a 2021 MacBook Pro “outside of ChatGPT,” then copied the numbers into its answer. While o3 has access to some tools, it can’t do that.

Zunächst ist es wichtig festhalten, dass „Halluzinieren“ nicht ein Bug, sondern schlicht die Funktionsweise von LLMs ist, denn für das Gegenteil bräuchten sie eine Verankerung in der Realiät. Das erstaunliche an LLMs ist nicht, dass sie „manchmal haluzinieren“, sondern dass ihre Haluzinationen manchmal stimmen. Und wenn die Haluzinationen stimmen, liegt das natürlich daran, dass sie erfolgreich Muster aus ´ Trainingsdaten rekonstruieren.

„Our hypothesis is that the kind of reinforcement learning used for o-series models may amplify issues that are usually mitigated (but not fully erased) by standard post-training pipelines,” said Neil Chowdhury, a Transluce researcher and former OpenAI employee, in an email to TechCrunch.

Hier meine These dazu: Wenn man versteht, dass der Latent Space – diese riesige Wolke aller semantischen Beziehungen – ein riesiges, tausenddimensionales Netzwerk ist, dessen Kanten sehr, sehr, sehr genau präzise abgemessen sind, dann wird auch klar, dass dieses Netzwerk als Gesamtheit eine „strukturelle Integrität“ besitzt.

Wenn man nun via „Reinforcement Learning“ an eigen wenigen Knoten des Netzwerkes zuppelt und zerrt, um sie mithilfe von Millionen extra Trainings-Cyclen besser auf irgendwelchen Benchmarks anzupassen, dann geht das nicht, ohne damit auch am Gesamtrahmen zu zerren und damit die strukturelle Integrität des Gesamtnetzwerks minimal zu verschieben. Und wahrscheinlich reicht die minimale Verzerrung, um die Trainingsdaten ungenauer zu matchen. Das Overfitting auf die Benchmarks bekommt den Modellen nicht gut.