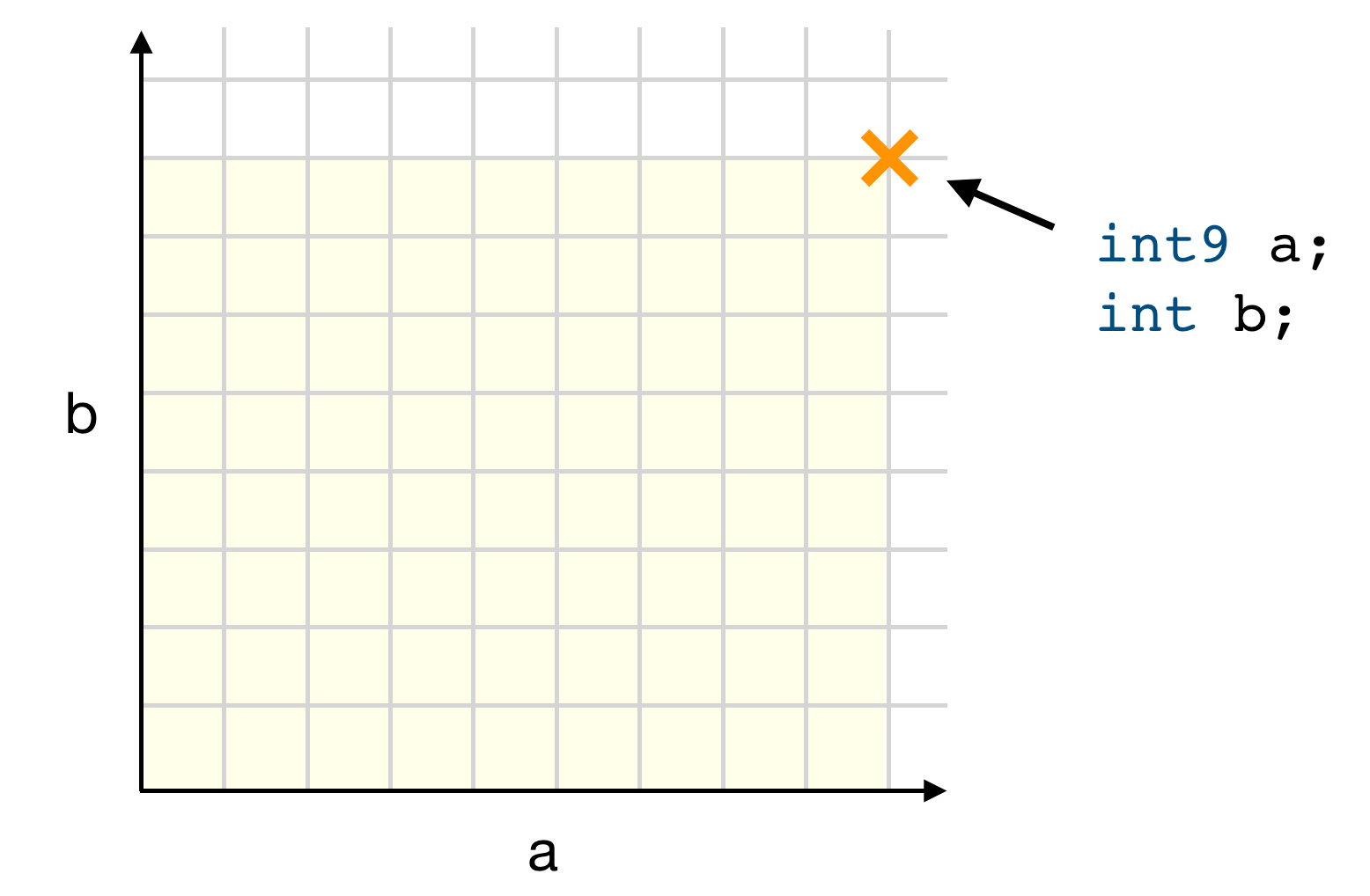

Les LLMs hallucinent des dépendances, des hackers malveillants les créent

Les modèles de langage (LLMs) génèrent fréquemment des noms de packages inexistants, ouvrant la voie au ‘slopsquatting’, une pratique malveillante où des attaquant·e·s exploitent ces références imaginaires pour créer de faux packages. Cette situation soulève des préoccupations importantes concernant la sécurité des développements assistés par l’IA. Commentaires L'article Les LLMs hallucinent des dépendances, des hackers malveillants les créent a été posté dans la catégorie Sécurité de Human Coders News

Les modèles de langage (LLMs) génèrent fréquemment des noms de packages inexistants, ouvrant la voie au ‘slopsquatting’, une pratique malveillante où des attaquant·e·s exploitent ces références imaginaires pour créer de faux packages. Cette situation soulève des préoccupations importantes concernant la sécurité des développements assistés par l’IA.

Commentaires

L'article Les LLMs hallucinent des dépendances, des hackers malveillants les créent a été posté dans la catégorie Sécurité de Human Coders News

/2024/12/04/maxpeopleworldtwo183567-67503e7d6bf62725451573.jpg?#)

/2025/04/16/capture-d-ecran-2025-04-16-075059-67ff65552341f534984245.jpg?#)

/2025/04/16/000-42g73bx-67ff494ca6435920306206.jpg?#)

/2025/04/15/aimons-nous-vivants-valery-lemercier-revient-dans-une-comedie-romantique-dejantee-aux-cotes-de-gerard-darmon-67fe777b7f4d0672502521.jpg?#)