Le fait de demander des réponses concises à des chatbots IA augmente leur tendance à halluciner, car les IA sacrifient la précision des faits quand elles donnent des réponses courtes, selon une nouvelle étude

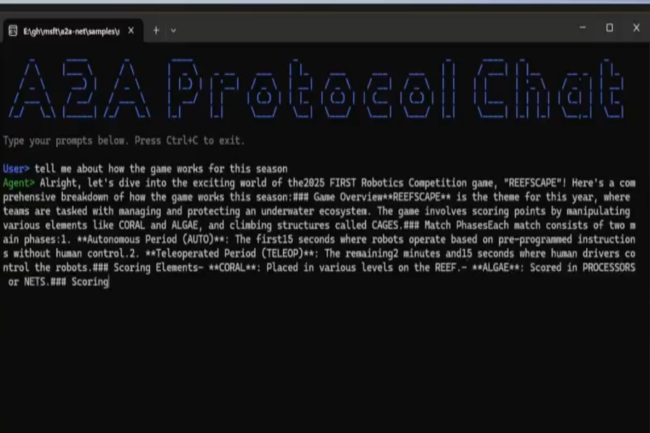

Le fait de demander des réponses concises à des chatbots IA augmente leur tendance à halluciner, car les IA sacrifient la précision des faits quand elles donnent des réponses courtes, selon une nouvelle étudeSelon une étude récente de Giskard, le fait de demander à l'un des chatbots d'intelligence artificielle (IA) les plus populaires d'être plus concis « a un impact considérable sur les taux d'hallucination ». L'étude a révélé que l'inclusion de ces instructions diminuait la résistance aux hallucinations...

Selon une étude récente de Giskard, le fait de demander à l'un des chatbots d'intelligence artificielle (IA) les plus populaires d'être plus concis « a un impact considérable sur les taux d'hallucination ». L'étude a révélé que l'inclusion de ces instructions diminuait la résistance aux hallucinations...

/2025/05/13/concert-montblanc-682360fe86afe697451386.jpg?#)

/2025/05/13/video-35-68236493c81b4568198651.jpg?#)

/2025/05/13/000-46hl4wh-68236687635d3245676698.jpg?#)

/2025/05/13/080-hl-rmacri-2765221-68235f2bc4634756756205.jpg?#)

![[Podcast] Comment fonctionne votre mémoire](https://www.radiofrance.fr/pikapi/images/154e9267-ad40-44b9-a266-f7b83e78ae6f/1280?webp=false)